Edge AI desafía la tecnología de memoria

Con el auge de la IA en el borde, surge una gran cantidad de nuevos requisitos para los sistemas de memoria. ¿Pueden las tecnologías de memoria de hoy estar a la altura de las estrictas demandas de esta nueva y desafiante aplicación, y qué prometen las tecnologías de memoria emergentes para la IA de borde a largo plazo?

Lo primero que hay que tener en cuenta es que no existe una aplicación estándar de "inteligencia artificial de borde"; el borde en su interpretación más amplia cubre todos los sistemas electrónicos habilitados para IA fuera de la nube. Eso podría incluir "near edge", que generalmente cubre los centros de datos empresariales y los servidores locales.

Más allá se encuentran aplicaciones como la visión por computadora para la conducción autónoma. Los equipos de puerta de enlace para la fabricación realizan inferencias de inteligencia artificial para verificar fallas en los productos en la línea de producción. Las “cajas de borde” 5G en los postes de servicios públicos analizan las transmisiones de video para aplicaciones de ciudades inteligentes como la gestión del tráfico. Y la infraestructura 5G utiliza IA en el borde para algoritmos de formación de haces complejos pero eficientes.

En el "extremo lejano", la IA es compatible con dispositivos como teléfonos móviles (piense en los filtros de Snapchat), el control por voz de los dispositivos y los nodos de sensores de IoT en las fábricas que realizan la fusión de sensores antes de enviar los resultados a otro dispositivo de puerta de enlace.

El papel de la memoria en los sistemas de inteligencia artificial de borde (para almacenar pesos de redes neuronales, código de modelo, datos de entrada y activaciones intermedias) es el mismo para la mayoría de las aplicaciones de inteligencia artificial. Las cargas de trabajo deben acelerarse para maximizar la capacidad de cómputo de IA a fin de seguir siendo eficientes, por lo que las demandas de capacidad y ancho de banda son generalmente altas. Sin embargo, las demandas específicas de la aplicación son muchas y variadas, y pueden incluir tamaño, consumo de energía, operación de bajo voltaje, confiabilidad, consideraciones térmicas / de enfriamiento y costo.

Centros de datos perimetrales

Los centros de datos de borde son un mercado de borde clave. Los casos de uso van desde imágenes médicas, investigación y algoritmos financieros complejos, donde la privacidad impide la carga a la nube. Otro son los vehículos autónomos, donde la latencia lo impide.

Estos sistemas utilizan las mismas memorias que se encuentran en los servidores de otras aplicaciones.

“Es importante utilizar DRAM de baja latencia para una memoria principal rápida a nivel de bytes en aplicaciones donde se están desarrollando y entrenando algoritmos de IA”, dijo Pekon Gupta, arquitecto de soluciones en Smart Modular Technologies, diseñador y desarrollador de productos de memoria. “Se necesitan RDIMM o LRDIMM de alta capacidad para conjuntos de datos grandes. Los NVDIMM son necesarios para la aceleración del sistema; los usamos para el almacenamiento en caché de escritura y puntos de control en lugar de SSD más lentos ".

Pekon Gupta

La ubicación de los nodos informáticos cerca de los usuarios finales es el enfoque adoptado por los operadores de telecomunicaciones.

"Estamos viendo una tendencia para hacer que estos servidores de borde [de telecomunicaciones] sean más capaces de ejecutar algoritmos complejos", dijo Gupta. Por lo tanto, "los proveedores de servicios están agregando más memoria y potencia de procesamiento a estos servidores de borde utilizando dispositivos como RDIMM, LRDIMM y memoria persistente de alta disponibilidad como NVDIMM".

Gupta ve a Intel Optane, la memoria no volátil 3D-Xpoint de la compañía cuyas propiedades se encuentran entre DRAM y Flash, como una buena solución para aplicaciones de inteligencia artificial de servidor.

“Tanto los DIMM de Optane como los NVDIMM se utilizan como aceleradores de inteligencia artificial”, dijo. “Los NVDIMM proporcionan capacidades de almacenamiento en niveles, almacenamiento en caché, almacenamiento en búfer de escritura y metadatos de muy baja latencia para la aceleración de aplicaciones de IA. Los DIMM del centro de datos de Optane se utilizan para la aceleración de bases de datos en memoria, donde se utilizan cientos de gigabytes a terabytes de memoria persistente en combinación con DRAM. Aunque ambas son soluciones de memoria persistente para aplicaciones de aceleración de AI / ML, tienen casos de uso diferentes y separados ".

Kristie Mann, directora de marketing de productos de Intel para Optane, dijo a EE Times Optane está ganando aplicaciones en el segmento de inteligencia artificial de servidores.

Kristie Mann de Intel

"Nuestros clientes ya están utilizando la memoria persistente Optane para impulsar sus aplicaciones de inteligencia artificial hoy", dijo. “Están impulsando el comercio electrónico, los motores de recomendación de video y los usos del análisis financiero en tiempo real con éxito. Estamos viendo un cambio a las aplicaciones en memoria debido a la mayor capacidad disponible ".

Los altos precios de las DRAM hacen de Optane una alternativa cada vez más atractiva. Un servidor con dos procesadores escalables Intel Xeon más memoria persistente Optane puede almacenar hasta 6 terabytes de memoria para aplicaciones que consumen mucha información.

“La DRAM sigue siendo la más popular, pero tiene sus limitaciones desde una perspectiva de costo y capacidad”, dijo Mann. “Nuevas tecnologías de memoria y almacenamiento como la memoria persistente Optane y Optane SSD están [emergiendo] como una alternativa a la DRAM debido a su ventaja de costo, capacidad y rendimiento. Los SSD de Optane son particularmente potentes para almacenar en caché datos de HDD y NAND SSD para alimentar continuamente los datos de las aplicaciones de IA ".

Optane también se compara favorablemente con otros recuerdos emergentes que no son completamente maduros o escalables en la actualidad, agregó.

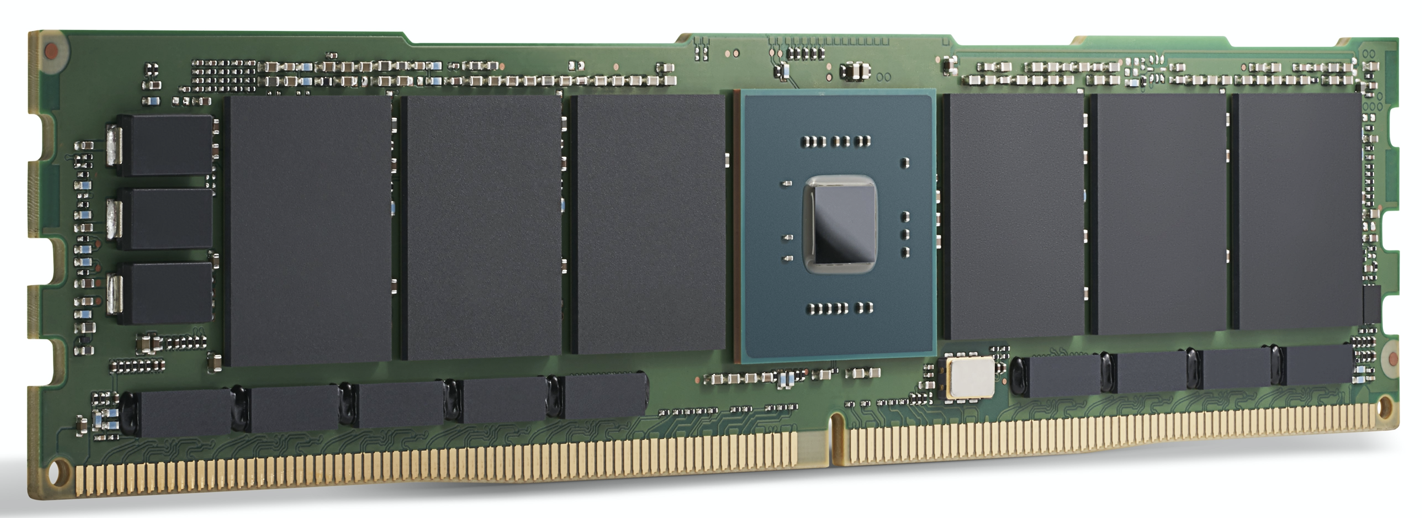

Un módulo Intel Optane 200 Series. Intel dice que Optane

ya se utiliza para impulsar aplicaciones de inteligencia artificial en la actualidad. (Fuente:Intel)

Aceleración de GPU

Para el centro de datos de borde de alta gama y las aplicaciones de servidor de borde, los aceleradores de cómputo de IA como las GPU están ganando terreno. Además de DRAM, las opciones de memoria aquí incluyen GDDR, una DDR SDRAM especial diseñada para alimentar GPU de alto ancho de banda, y HBM, una tecnología de apilamiento de matrices relativamente nueva que coloca varias matrices de memoria en el mismo paquete que la propia GPU.

Ambos están diseñados para el ancho de banda de memoria extremadamente alto requerido por las aplicaciones de IA.

Para el entrenamiento de modelos de IA más exigente, HBM2E ofrece 3.6 Gbps y proporciona un ancho de banda de memoria de 460 GB / s (dos pilas HBM2E proporcionan cerca de 1 TB / s). Se encuentra entre las memorias de mayor rendimiento disponibles, en el área más pequeña con el menor consumo de energía. HBM es utilizado por Nvidia, líder en GPU, en todos sus productos de centro de datos.

GDDR6 también se utiliza para aplicaciones de inferencia de IA en el borde, dijo Frank Ferro, director senior de marketing de productos para IP Cores en Rambus. Ferro dijo que GDDR6 puede cumplir con los requisitos de velocidad, costo y potencia de los sistemas de inferencia de IA de borde. Por ejemplo, GDDR6 puede ofrecer 18 Gbps y 72 GB / s. Tener cuatro DRAM GDDR6 proporciona cerca de 300 GB / s de ancho de banda de memoria.

“GDDR6 se usa para aplicaciones de inferencia de IA y ADAS, agregó Ferro.

Al comparar GDDR6 con LPDDR, el enfoque de Nvidia para la mayoría de las soluciones de borde que no son de centros de datos, desde Jetson AGX Xavier hasta Jetson Nano, Ferro reconoció que LPDDR es adecuado para inferencias de IA de bajo costo en el borde o en el punto final.

“El ancho de banda de LPDDR está limitado a 4.2 Gbps para LPDDR4 y 6.4 Gbps para LPDDR5”, dijo. “A medida que aumentan las demandas de ancho de banda de memoria, veremos un número creciente de diseños que utilizan GDDR6. Esta brecha de ancho de banda de memoria está ayudando a impulsar la demanda de GDDR6 ”.

Frank Ferro de Rambus

A pesar de estar diseñado para adaptarse a las GPU, otros aceleradores de procesamiento pueden aprovechar el ancho de banda de GDDR. Ferro destacó el Achronix Speedster7t, un acelerador de IA basado en FPGA que se utiliza para inferencias y algunos entrenamientos de gama baja.

“Hay espacio para memorias HBM y GDDR en aplicaciones de inteligencia artificial de borde”, dijo Ferro. HBM “seguirá utilizándose en aplicaciones de borde. A pesar de todas las ventajas de HBM, el coste sigue siendo elevado debido a la tecnología 3D y la fabricación 2.5D. Dado esto, GDDR6 es una buena compensación entre costo y rendimiento, especialmente para AI Inference en la red ".

HBM se utiliza en ASIC de AI de centros de datos de alto rendimiento como Graphcore IPU. Si bien ofrece un rendimiento estelar, su precio puede ser elevado para algunas aplicaciones.

Qualcomm se encuentra entre los que utilizan este enfoque. Su Cloud AI 100 apunta a la aceleración de la inferencia de inteligencia artificial en centros de datos de borde, "cajas de borde" 5G, ADAS / conducción autónoma e infraestructura 5G.

“Para nosotros era importante usar DRAM estándar en lugar de algo como HBM, porque queremos mantener baja la lista de materiales”, dijo Keith Kressin, gerente general de la unidad de Computación y Edge Cloud de Qualcomm. “Queríamos utilizar componentes estándar que pueda comprar a varios proveedores. Tenemos clientes que quieren hacer todo en chip y tenemos clientes que quieren utilizar tarjetas cruzadas. Pero todos querían mantener un costo razonable y no optar por HBM o incluso un recuerdo más exótico.

"En el entrenamiento", continuó, "tienes modelos realmente grandes que atravesarían [múltiples chips], pero por inferencia [el mercado de Cloud AI 100], muchos de los modelos están más localizados".

El extremo más alejado

Fuera del centro de datos, los sistemas de inteligencia artificial de borde generalmente se enfocan en la inferencia, con algunas excepciones notables, como el aprendizaje federado y otras técnicas de capacitación incremental.

Algunos aceleradores de IA para aplicaciones sensibles a la energía utilizan memoria para el procesamiento de IA. La inferencia, que se basa en la multiplicación de matrices multidimensionales, se presta a técnicas de cálculo analógico con una matriz de celdas de memoria que se utilizan para realizar cálculos. Con esta técnica, los dispositivos de Syntiant están diseñados para el control por voz de los dispositivos electrónicos de consumo, y los dispositivos de Gyrfalcon se han diseñado en un teléfono inteligente donde manejan la inferencia para los efectos de la cámara.

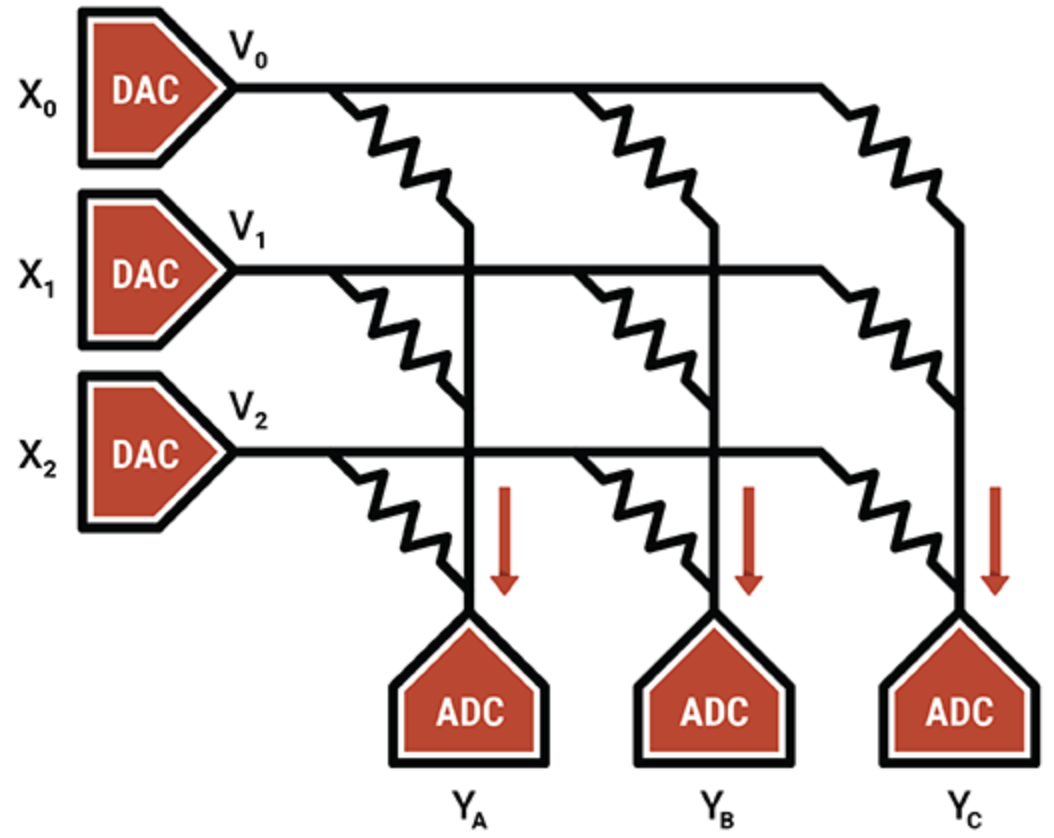

En otro ejemplo, el especialista en unidades de procesamiento inteligente Mythic utiliza la operación analógica de las celdas de memoria flash para almacenar un valor entero de 8 bits (un parámetro de peso) en un solo transistor flash, lo que lo hace mucho más denso que otras tecnologías de computación en memoria. El transistor flash programado funciona como una resistencia variable; las entradas se suministran como tensiones y las salidas se recogen como corrientes. Combinado con ADC y DAC, el resultado es un motor eficiente de multiplicación de matrices.

La IP de Mythic reside en las técnicas de compensación y calibración que cancelan el ruido y permiten un cálculo confiable de 8 bits.

Mythic utiliza una serie de transistores de memoria Flash para hacer motores densos de acumulación múltiple (Fuente:Mythic)

Además de los dispositivos de computación en memoria, los ASIC son populares para nichos de borde específicos, particularmente para sistemas de baja y ultrabaja energía. Los sistemas de memoria para ASIC utilizan una combinación de varios tipos de memoria. La SRAM local distribuida es la más rápida, la más eficiente en cuanto a energía, pero no muy eficiente en el área. Tener una única SRAM a granel en el chip es más eficiente en el área, pero introduce cuellos de botella en el rendimiento. La DRAM fuera de chip es más barata pero consume mucha más energía.

Geoff Tate, CEO de Flex Logix, dijo que encontrar el equilibrio adecuado entre SRAM distribuida, SRAM masiva y DRAM fuera de chip para su InferX X1 requería una gama de simulaciones de rendimiento. El objetivo era maximizar el rendimiento de la inferencia por dólar, una función del tamaño de la matriz, el costo del paquete y la cantidad de DRAM utilizadas.

“El punto óptimo fue una única DRAM LPDDR4 x32; MAC 4K (7.5 TOPS a 933MHz); y alrededor de 10 MB de SRAM ”, dijo. “La SRAM es rápida, pero es cara en comparación con la DRAM. Con la tecnología de proceso de 16 nm de TSMC, 1 MB de SRAM requiere aproximadamente 1,1 mm 2 . “Nuestro InferX X1 mide solo 54 mm 2 y debido a nuestra arquitectura, los accesos a DRAM se superponen en gran medida con la computación, por lo que no hay un límite de rendimiento. Para modelos grandes, tener una sola DRAM es la compensación correcta, al menos con nuestra arquitectura ”, dijo Tate.

El chip Flex Logix se utilizará en aplicaciones de inferencia de IA de borde que requieren operación en tiempo real, incluido el análisis de transmisión de video con baja latencia. Esto incluye sistemas ADAS, análisis de imágenes de seguridad, imágenes médicas y aplicaciones de control / inspección de calidad.

¿Qué tipo de DRAM se incluirá junto con InferX X1 en estas aplicaciones?

"Creemos que LPDDR será el más popular:una sola DRAM proporciona más de 10 GB / seg de ancho de banda ... pero tiene suficientes bits para almacenar los pesos / activaciones intermedias", dijo Tate. "Cualquier otra DRAM requeriría más chips e interfaces y se necesitarían comprar más bits que no se utilizan".

¿Hay espacio para alguna tecnología de memoria emergente aquí?

"El costo de la oblea aumenta drásticamente cuando se usa cualquier memoria emergente, mientras que SRAM es 'gratis', excepto en el área de silicio", agregó. "A medida que cambie la economía, el punto de inflexión también podría cambiar, pero será más adelante".

Recuerdos emergentes

A pesar de la economía de escala, otros tipos de memoria tienen posibilidades futuras para aplicaciones de inteligencia artificial.

MRAM (RAM magnetorresistiva) almacena cada bit de datos a través de la orientación de los imanes controlados por un voltaje eléctrico aplicado. Si el voltaje es menor que el requerido para invertir el bit, solo existe la probabilidad de que un bit cambie. Esta aleatoriedad no es deseada, por lo que MRAM se maneja con voltajes más altos para evitarla. Aún así, algunas aplicaciones de IA pueden aprovechar esta inherente stochasity (que se puede considerar como el proceso de seleccionar o generar datos aleatoriamente).

Los experimentos han aplicado las capacidades de stochasity de MRAM a los dispositivos de Gyrfalcon, una técnica mediante la cual la precisión de todos los pesos y activaciones se reduce a 1 bit. Esto se utiliza para reducir drásticamente los requisitos de computación y energía para aplicaciones de última generación. Es probable que haya compensaciones con la precisión, dependiendo de cómo se reentrena la red. En general, se puede hacer que las redes neuronales funcionen de manera confiable a pesar de la precisión reducida.

“Las redes neuronales binarizadas son únicas porque pueden funcionar de manera confiable incluso cuando se reduce la certeza de que un número sea -1 o +1”, dijo Andy Walker, vicepresidente de producto de Spin Memory. “Hemos descubierto que tales BNN aún pueden funcionar con altos niveles de precisión, ya que esta certeza se reduce [al] introducir lo que se llama 'tasa de error de bits' de los bits de memoria que se escriben incorrectamente”.

Andy Walker de Spin Memory

MRAM puede introducir naturalmente tasas de error de bits de manera controlada a niveles de voltaje bajo, manteniendo la precisión y reduciendo aún más los requisitos de energía. La clave es determinar la precisión óptima con el voltaje más bajo y el tiempo más corto. Eso se traduce en la mayor eficiencia energética, dijo Walker.

Si bien esta técnica también se aplica a redes neuronales de mayor precisión, es especialmente adecuada para BNN porque la celda MRAM tiene dos estados, que coinciden con los estados binarios en un BNN.

El uso de MRAM en el borde es otra aplicación potencial, según Walker.

"Para la inteligencia artificial de borde, MRAM tiene la capacidad de funcionar a voltajes más bajos en aplicaciones donde la precisión de alto rendimiento no es un requisito, pero las mejoras en la eficiencia energética y la resistencia de la memoria son muy importantes", dijo. “Además, la no volatilidad inherente de MRAM permite la conservación de datos sin energía.

Una aplicación es la denominada memoria unificada "donde esta memoria emergente puede actuar como un flash integrado y reemplazo de SRAM, ahorrando área en el dado y evitando la disipación de energía estática inherente a SRAM".

Si bien el MRAM de Spin Memory está a punto de ser adoptado comercialmente, la implementación específica del BNN funcionaría mejor en una variante de la celda MRAM básica. Por lo tanto, permanece en la etapa de investigación.

ReRAM neuromórfico

Otra memoria emergente para aplicaciones de inteligencia artificial de borde es ReRAM. Una investigación reciente del Politécnico de Milán que utilizó la tecnología ReRAM de óxido de silicio (SiOx) de Weebit Nano mostró ser prometedora para la computación neuromórfica. ReRAM agregó una dimensión de plasticidad al hardware de la red neuronal; es decir, podría evolucionar a medida que cambian las condiciones, una cualidad útil en la computación neuromórfica.

Las redes neuronales actuales no pueden aprender sin olvidar las tareas en las que han sido entrenados, mientras que el cerebro puede hacerlo con bastante facilidad. En términos de IA, esto es "aprendizaje no supervisado", donde el algoritmo realiza inferencias en conjuntos de datos sin etiquetas, buscando sus propios patrones en los datos. El resultado final podría ser sistemas de inteligencia artificial de borde habilitados para ReRAM que puedan aprender nuevas tareas in situ y adaptarse al entorno que las rodea.

En general, los fabricantes de memoria están introduciendo tecnologías que ofrecen la velocidad y el ancho de banda necesarios para las aplicaciones de IA. Varias memorias, ya sea en el mismo chip que el cómputo de AI, en el mismo paquete o en módulos separados, están disponibles para adaptarse a muchas aplicaciones de AI de borde.

Si bien la naturaleza exacta de los sistemas de memoria para la inteligencia artificial de borde depende de la aplicación, GDDR, HBM y Optane están demostrando ser populares para los centros de datos, mientras que LPDDR compite con SRAM en chip para aplicaciones de punto final.

Los recuerdos emergentes están prestando sus propiedades novedosas a la investigación diseñada para hacer avanzar las redes neuronales más allá de las capacidades del hardware actual para permitir futuros sistemas inspirados en el cerebro y de bajo consumo energético.

>> Este artículo se publicó originalmente el nuestro sitio hermano, EE Times.

Incrustado

- Memoria de solo lectura (ROM)

- Microprocesadores

- Big Data, no es fácil:superando nuevos desafíos en la tecnología de mantenimiento de fábrica

- Memoria de cambio de fase incorporada de muestreo ST para microcontroladores automotrices

- Siemens adquirirá la tecnología Edge de Pixeom

- Edge Application Technology beneficia a todas las industrias

- 5G y Edge plantean nuevos desafíos de ciberseguridad para 2021

- 4 consejos y desafíos para una mejor gestión de activos de IIoT

- 3 ejemplos principales de tecnología de fabricación avanzada de vanguardia

- Tecnología de movimiento lineal

- Cómo la tecnología conectada puede ayudar a resolver los desafíos de la cadena de suministro