La historia de la IA:de la ficción futurista al futuro de la empresa

Di las palabras "inteligencia artificial" y la mayoría de la gente piensa en Alexa y Siri. Otros pueden pensar en películas como The Terminator o 2001:A Space Odyssey.

Lo cierto es que la inteligencia artificial (IA) no es un concepto lejano de ciencia ficción. De hecho, está en todas partes a nuestro alrededor:piense en Netflix recomendando su próximo programa de televisión o en Uber optimizando la mejor ruta a casa.

La IA es un ecosistema sofisticado de tecnologías modernas e interconectadas que ha evolucionado durante décadas y continúa evolucionando en la actualidad. Por lo tanto, no debería sorprender que la historia de la IA también sea compleja y de múltiples capas. Es una historia que presenta una variedad de herramientas y capacidades cambiantes que han desarrollado la IA tal como la conocemos hasta su estado actual.

Para comprender la importancia de la IA hoy, y prepararse para el mañana, es útil comprender dónde comenzó la IA y cómo evolucionó para convertirse en la tecnología revolucionaria que es hoy.

IA del siglo XX:una ambiciosa prueba de concepto

La IA moderna nació en las cámaras académicas de los departamentos de investigación universitarios de élite, donde los académicos reflexionaron profundamente sobre el futuro de la informática. Pero sus primeros años lo dejaron confinado en estas cámaras, varado gracias a la falta de datos y potencia informática.

En 1956, Dartmouth College organizó el Proyecto de investigación de verano de Dartmouth sobre inteligencia artificial, un taller que llegó a ser conocido como un primer paso fundamental en la investigación académica de la IA. Durante el taller, 20 investigadores intentaron probar la hipótesis de que el aprendizaje podría describirse con tanta precisión "que se puede hacer una máquina para simularlo".

Un año más tarde, en 1957, el psicólogo estadounidense Frank Rosenblatt amplió la investigación de Dartmouth con el perceptrón, un algoritmo que podía realizar con éxito la clasificación binaria. Aquí fue donde comenzamos a ver evidencia prometedora de cómo las neuronas artificiales podrían aprender de los datos.

Y otro año después, John McCarthy, asistente al Proyecto de Investigación de Verano de Dartmouth sobre Inteligencia Artificial, y numerosos estudiantes del MIT, desarrollaron Lisp (un nuevo lenguaje de programación). Décadas más tarde, la investigación de McCarthy ayudaría a dar vida a proyectos nuevos e incluso más emocionantes, incluido el programa de lenguaje natural SHRDLU, el sistema de álgebra Macsyma y el sistema lógico ACL2.

Fuente

Al mirar hacia atrás a estos primeros experimentos, podemos ver que la IA está dando sus primeros y vacilantes pasos del mundo de la investigación altruista al mundo práctico de la computación.

El año 1960 vio el debut de Simulmatics, una empresa que afirmaba que podía predecir cómo votaría la gente en función de su demografía.

En 1965, los investigadores desarrollaron los llamados "sistemas expertos". Estos sistemas permitieron a la IA resolver problemas especializados dentro de los sistemas informáticos mediante la combinación de una colección de hechos y un motor de inferencia para interpretar y evaluar datos.

Luego, un año después, en 1966, el profesor del MIT Joseph Weizenbaum diseñó un programa de coincidencia de patrones llamado Eliza que mostró a los usuarios que la IA era inteligente. Los usuarios podían dar información al programa y Eliza, actuando como psicoterapeuta, les respondía con una pregunta abierta.

A mediados de la década de 1970, los gobiernos y las corporaciones estaban perdiendo la fe en la IA. La financiación se agotó y el período que siguió se conoció como el "invierno de la IA". Si bien hubo pequeños resurgimientos en las décadas de 1980 y 1990, la IA se relegó principalmente al ámbito de la ciencia ficción y los científicos informáticos serios evitaron el término.

Desde finales de la década de 1990 hasta principios de la de 2000, vimos la aplicación a gran escala de técnicas de aprendizaje automático, como los métodos bayesianos para el filtrado de spam por parte de Microsoft y el filtrado colaborativo para las recomendaciones de Amazon.

IA del siglo XXI:Programas piloto tremendamente exitosos

En la década de 2000, la potencia informática, los conjuntos de datos más grandes y el auge del software de código abierto permitieron a los desarrolladores crear algoritmos avanzados que revolucionarían las comunidades científica, de consumo, de fabricación y empresarial en un tiempo relativamente corto. La IA se ha convertido en una realidad para muchas empresas en la actualidad. McKinsey, por ejemplo, ha encontrado 400 ejemplos en los que las empresas utilizan actualmente la IA para abordar problemas comerciales.

La web ofrece nuevas formas de organizar los datos

La revolución web que barrió el mundo a principios y mediados de la década de 2000 dejó algunos cambios importantes en el mundo de la investigación de IA. Las tecnologías fundamentales, como el Lenguaje de marcado extensible (XML) y PageRank, organizaron los datos de nuevas formas que la IA podría usar.

XML era una condición previa para la web semántica y para los motores de búsqueda. PageRank, una de las primeras innovaciones de Google, organizó aún más la web. Estos avances hicieron que la web fuera más útil y que grandes cantidades de datos fueran más accesibles para la IA.

Al mismo tiempo, las bases de datos estaban mejorando en el almacenamiento y la recuperación de datos, mientras que los desarrolladores trabajaban en lenguajes de programación funcionales que facilitaban la operación de esos datos. Las herramientas estuvieron presentes para los investigadores y desarrolladores para promover la tecnología de IA.

Las redes neuronales y el aprendizaje profundo demuestran el potencial de la IA

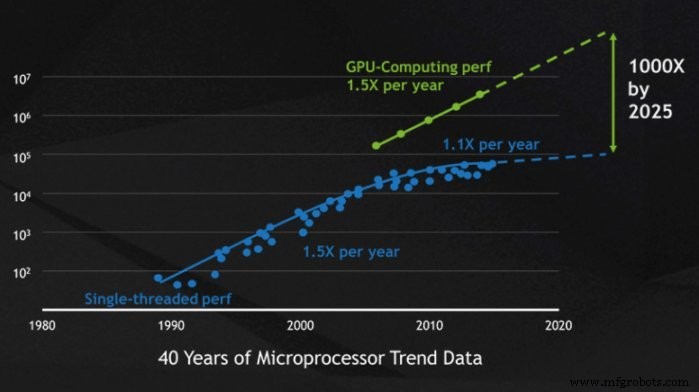

Hubo grandes sueños para la IA en el siglo XX, pero el poder de la computación los había hecho casi imposibles de construir. Sin embargo, para el siglo XXI, las computadoras se estaban volviendo exponencialmente más poderosas para almacenar, procesar y analizar grandes volúmenes de datos. Esto significó que los elevados objetivos de las redes neuronales y el aprendizaje profundo podrían convertirse en realidad.

Los investigadores desarrollaron conjuntos de datos que se adaptaron específicamente para el entrenamiento de máquinas, lo que dio como resultado redes neuronales como AlexNet. Anteriormente, el entrenamiento de máquinas se basaba en conjuntos de datos que sumaban decenas de miles, pero el avance de las unidades de procesamiento de gráficos (GPU) significaba que los nuevos conjuntos de datos podían contarse por decenas de millones.

El fabricante de chips de computadora Nvidia lanzó su plataforma de computación paralela, CUDA, en 2006. Dentro de esta plataforma, Nvidia usó GPU para acelerar su computación. Este aumento del rendimiento ayudó a más personas a ejecutar modelos de aprendizaje automático grandes y complejos escritos en bibliotecas de aprendizaje automático, como TensorFlow y PyTorch.

Fuente

En el futuro, estas bibliotecas se convertirían en código abierto e inspirarían una experimentación generalizada a medida que la tecnología se volviera más accesible. Esta democratización de la IA ayudaría a que despeguen nuevas e interesantes herramientas como AlphaGo, Google DeepMind e IBM Deep Blue.

La visión artificial abre la puerta a nuevas aplicaciones industriales

Hasta la década de 2000, la IA solo era realmente útil si estaba procesando texto. Pero a principios de siglo, los avances en la visión por computadora, que permitieron que las computadoras reconocieran e interpretaran imágenes, llevaron los casos de uso de la IA a nuevas alturas.

Esta vez, nuestros pioneros no fueron académicos. En su lugar, vivían dentro de su hogar e hicieron que la limpieza (Roomba) y los juegos (XBox Kinect) fueran más fáciles que nunca y pusieron la visión artificial en hogares de todo el mundo.

También vimos el uso de la visión por computadora en automóviles autónomos emergentes y en hospitales para detectar automáticamente afecciones como lesiones y neumonía.

Más allá de los casos de uso específicos de la industria, la variación de la visión por computadora también ayudó a impulsar el avance de la automatización robótica de procesos (RPA). 🎉 Complementados con el reconocimiento óptico de caracteres (OCR), los robots RPA pueden procesar datos estructurados y no estructurados, lo que ha cambiado el mundo del análisis de datos tal como lo conocemos.

El análisis de datos mejora las aplicaciones empresariales de IA

Las últimas dos décadas nos han demostrado que la automatización y la IA pueden compararse con casos de uso empresarial complejos. Y a medida que la IA mejora aún más el análisis de datos, las empresas pueden aprovechar la IA aún más para ayudarlas a trabajar de manera más inteligente y eficiente.

Los bancos están utilizando IA para clasificar las consultas de los clientes en diferentes categorías a partir del gran volumen de correos electrónicos no estructurados recibidos anualmente. Este proceso requiere mucho trabajo manual o genera resultados deficientes cuando se utiliza la clasificación de palabras clave basada en reglas. La IA permite a los bancos clasificar estos correos electrónicos con altos niveles de precisión y reducir el tiempo promedio de manejo (AHT).

La IA y la automatización no solo ayudan a las empresas de servicios financieros. Los pagadores de atención médica están acelerando la identificación de embarazos de alto riesgo. El robot de software carga datos verificados del paciente y accede a un modelo predictivo para calificar al paciente según los riesgos, determina el plan de gestión de la atención adecuado. Los resultados aumentan en un 24 % la cantidad de embarazos con bajo peso al nacer que se identificaron con precisión y evitan un 44 % de embarazos con bajo peso al nacer, lo que supone un ahorro total de $11 millones al año. Lea la historia completa.

El procesamiento del lenguaje natural y el reconocimiento de voz aumentan la usabilidad de la IA

Aunque AI comenzó con el análisis de texto, de ninguna manera lo domina. Hasta hace poco, el texto, incluso con OCR, debía estructurarse en formatos legibles por máquina. El campo del procesamiento del lenguaje natural (PNL) ha impulsado la capacidad de programar computadoras para comprender el lenguaje natural.

Uno de los ejemplos más conocidos de NLP es Generative Pre-trained Transformer 3 (más conocido como GPT-3). GPT-3, presentado en mayo de 2020, utiliza el aprendizaje profundo para generar texto que se parece mucho al texto hecho por humanos. Ya han surgido aplicaciones interesantes para GPT-3, como escribir artículos (The Guardian, por ejemplo, encargó a GPT-3 que escribiera un artículo sobre la inocuidad de los robots) y generar programas informáticos.

Las aplicaciones de PNL se extienden más allá de GPT-3. La PNL se puede usar para crear texto a partir del habla, resumir automáticamente el significado de un fragmento de texto, traducir texto entre idiomas y más.

Aunque la PNL a menudo existe a la vanguardia, también se ha abierto camino en nuestros hogares. Los asistentes virtuales como Alexa y Google, por ejemplo, pueden procesar solicitudes en lenguaje natural y traducirlas en comandos ejecutables. Con una simple solicitud de voz, estos asistentes de IA pueden buscar información; enrutar comandos a dispositivos inteligentes, como luces o cerraduras; y más.

El futuro de la IA:un cambio de juego empresarial

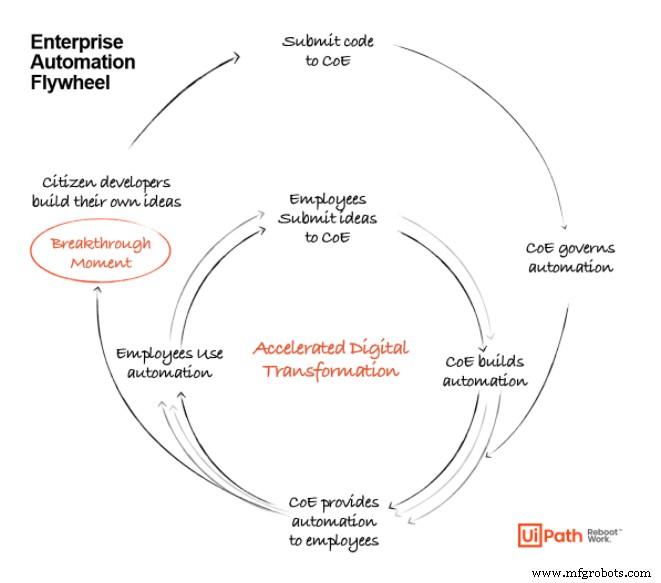

A medida que avanzamos hacia la próxima década de madurez tecnológica, los casos de uso empresarial para la IA seguirán creciendo. Las herramientas anteriores han sentado las bases de lo que es posible con la IA, pero aún queda mucho camino por recorrer al llevar estas herramientas a escala.

A medida que la IA avance aún más, veremos que las empresas aprovechan la RPA, el aprendizaje automático, la minería de procesos y el análisis de datos para crear un potente conjunto de automatización integral a medida que estas tecnologías se vuelven cada vez más accesibles para las empresas en todas las etapas de madurez. . La IA ya no será dominio exclusivo de investigadores y desarrolladores; los usuarios cotidianos, con la ayuda de herramientas modernas, podrán crear soluciones basadas en IA para los problemas que identifiquen.

A medida que la tecnología se vuelve más accesible para los usuarios comerciales, veremos cómo gira el volante de la automatización para brindar a las empresas más y más ideas y posibilidades para las aplicaciones de IA. Estas posibilidades estarán respaldadas por plataformas y herramientas de automatización de vanguardia que reiniciarán y revolucionarán la forma en que trabajamos.

UiPath AI Fabric facilita a los usuarios el lanzamiento de un modelo, el envío de datos, la obtención de información y la evaluación de la utilidad.

Nota del editor: A medida que el mercado de la automatización sigue evolucionando, la plataforma UiPath también se actualiza para satisfacer mejor las necesidades de automatización de nuestros clientes. Como tal, el nombre del producto AI Fabric ha evolucionado desde que se publicó originalmente el artículo. Para obtener información actualizada, por favor visite nuestra página del Centro de IA .

IA hoy:el momento adecuado para empezar

Es hora de automatizar. Hemos llegado a la etapa en la evolución de la IA en la que no es teórica:es imperativa y se prevé que desbloqueará cientos de miles de millones de dólares en valor para las empresas que la adopten.

Descubra cómo las organizaciones líderes están utilizando la automatización y la IA para hacer realidad la visión de convertirse en una empresa completamente automatizada™:

Sistema de control de automatización

- El futuro de la entrega sin contacto

- La historia y el futuro de la extrusión de aluminio

- Boston Dynamics y Trimble:el futuro de la construcción

- Fábricas del Futuro:Fabricación Industrial 1.0 a 4.0

- La fábrica 'consciente' del futuro de Nokia

- El futuro de la ingeniería de mantenimiento

- ¿Automatización y el futuro de la fabricación digital?

- El Origen del Concepto de Aserrado:Historia y Futuro

- ¿Qué esperar del fresado CNC en el futuro?

- Bienvenido al futuro de la visión 3D

- Cobots frente a robots:el futuro de la fabricación