Herramientas Suben en la cadena de valor para eliminar el misterio de la visión AI

Los beneficios de agregar visión a los productos cotidianos han atraído la atención de muchas industrias y sectores. Pero, ¿cómo se obtienen datos de una cámara, se incrusta el aprendizaje automático en el dispositivo para llevar a cabo el algoritmo de inferencia y se permite procesar algo útil?

La respuesta, como en cualquier diseño de sistema, es tener el software, las herramientas, las bibliotecas, los compiladores, etc. adecuados. No es de extrañar que, por lo general, tales capacidades estén más allá del alcance de quienes no son ingenieros. Pero incluso entre los desarrolladores de sistemas integrados, se considera que escasean los conocimientos y las habilidades necesarios para el diseño de sistemas de visión.

Uno de los grandes desafíos es la falta de conocimiento del software y las herramientas disponibles para desarrollar sistemas de visión integrados, como explicó Jeff Bier, fundador de Edge AI and Vision Alliance, en una sesión informativa con EE Times antes de la Cumbre de Visión Integrada de 2021 . Si bien ha habido una inversión e investigación significativas sobre los algoritmos y el silicio, las herramientas de software que median entre ellos (compiladores, bibliotecas de funciones optimizadas, etc.) se han descuidado un poco, dijo Bier.

El uso de las herramientas de software, los compiladores y las bibliotecas adecuadas puede producir una implementación muy eficiente de un algoritmo para un microcontrolador o procesador en particular. Pero "durante los últimos 30 años, las empresas de semiconductores normalmente han invertido poco en herramientas de software", dijo Bier, un veterano de la industria de sistemas integrados y el procesamiento de señales en particular. “[El software] a menudo se ve como un mal necesariamente, es un centro de costos en una empresa muy sensible a los costos, y se nota. Como desarrollador de software integrado, podría comparar las herramientas disponibles [para usted] con las que tienen los desarrolladores de PC o nube y sentirse como un hijastro no querido ".

Llevando este argumento al siguiente nivel, agregó:"Es posible que tenga experiencia en sistemas integrados, pero existe la posibilidad de que estos desarrolladores nunca hayan trabajado con datos de imágenes o redes neuronales profundas".

Las habilidades son un gran desafío, dijo Bier. “Es posible que hayamos hecho algunos cálculos con hojas de cálculo y dijimos:'Sí, es posible ejecutar este tipo de red neuronal profunda con un rendimiento suficiente en nuestra aplicación'. Pero, ¿sabemos cómo hacerlo? ¿Tenemos las habilidades? Para la mayoría de las organizaciones, la respuesta es no, porque no han tenido la oportunidad de utilizar esta tecnología en el pasado. Dado que es una tecnología relativamente nueva en el mundo comercial, no tienen la experiencia. No tienen un departamento de aprendizaje automático ni un departamento de visión por computadora en su empresa.

“En los últimos años, esto se ha convertido en un cuello de botella realmente grande con respecto a la aplicación comercial de visión por computadora y redes neuronales profundas, solo los conocimientos técnicos”.

Sin embargo, la tecnología se está volviendo más accesible, ya que las empresas han tratado de abordar la brecha de habilidades en los últimos años. "La brecha de conocimientos y habilidades ha sido bastante grande, pero se está reduciendo", dijo Bier, y agregó que "un par de empresas", una grande y otra pequeña, "han liderado la carga en esto". La gran empresa es Intel; el pequeño es Edge Impulse.

“A menudo, Intel me ha impresionado por oponerse a la tendencia y por estar dispuesto a realizar grandes inversiones en herramientas de software de varias formas”, dijo Bier. “Tienen, por ejemplo, la cadena de herramientas OpenVINO para visión e inferencia por computadora de vanguardia, y DevCloud para Edge. Edge Impulse también es un entorno basado en la nube. Para un desarrollador integrado, [el entorno de la nube] se siente extraño. Para ellos, todo está a menudo en su escritorio (la placa de desarrollo, la estación de trabajo, las herramientas) y ni siquiera necesitan una conexión a Internet. Todo es muy local. Entonces, se siente muy extraño decir:"Pon tu código en la nube" y ejecuta las herramientas en la nube ".

La tendencia aborda el tiempo de implementación y la brecha de habilidades. Una frustración frecuente para los desarrolladores integrados es tener acceso a placas y herramientas e instalarlas correctamente, dijo Bier. La línea de tiempo "generalmente se mide en semanas, a veces en meses, y eso es doloroso, especialmente si al final te das cuenta de que no es lo que necesitabas y necesitas repetir el proceso con algunos otros tableros". Por ejemplo, puede encontrar al final del proceso que "necesita el siguiente, con mayor rendimiento o un conjunto diferente de interfaces de E / S".

Pero si el proveedor “tiene todas las placas de desarrollo en la nube conectadas a sus máquinas y [puede] acceder a ellas a voluntad, eso ofrece una gran comodidad. Asimismo, han obtenido las últimas versiones de las herramientas de software y han resuelto todas las dependencias entre ellas ".

Allanando el camino para implementar la visión

Entonces, ¿cómo se acelera la implementación de la visión integrada para habilitar funciones como la detección y el análisis de objetos, ya sea para ciudades inteligentes, fábricas, comercio minorista o cualquier otra aplicación?

Al darse cuenta de los puntos débiles descritos por Bier, las empresas los están abordando. Algunos ahora ofrecen herramientas como los sistemas de desarrollo basados en la nube que le permiten alimentar su código o datos y obtener evaluaciones en muy poco tiempo. Otros proporcionan diseños de referencia que le permiten simplemente conectar la salida de su cámara y elegir entre bibliotecas o aplicaciones que brindan algoritmos de inferencia para aplicaciones comunes.

En el primer campo, Intel DevCloud para Edge y Edge Impulse ofrecen plataformas basadas en la nube que eliminan la mayoría de los puntos débiles con un fácil acceso a las últimas herramientas y software. En este último, Xilinx y otros han comenzado a ofrecer sistemas completos en módulo con aplicaciones listas para producción que se pueden implementar con herramientas en un nivel superior de abstracción, eliminando la necesidad de algunas de las habilidades más especializadas.

Prototipa, compara y prueba la inferencia de IA en la nube

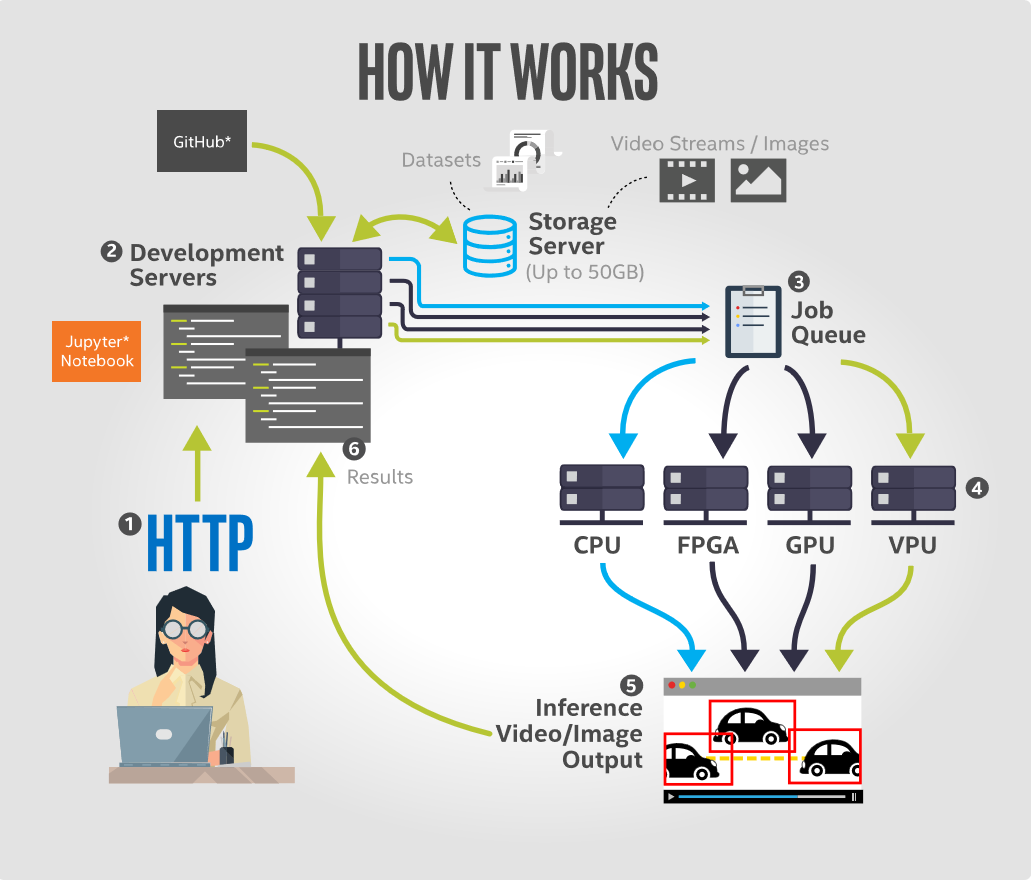

Intel DevCloud for the Edge permite a los usuarios desarrollar, crear prototipos, comparar y probar aplicaciones de inferencia de IA en una variedad de hardware Intel, incluidas CPU, GPU integradas, FPGA y unidades de procesamiento de visión (VPU). Con su interfaz Jupyter Notebook, la plataforma contiene tutoriales y ejemplos precargados con todo lo necesario para comenzar a funcionar rápidamente. Esto incluye modelos previamente entrenados, datos de muestra y código ejecutable de la última versión de la distribución Intel del kit de herramientas OpenVINO, así como otras herramientas para el aprendizaje profundo. Todos los dispositivos compatibles están configurados para un rendimiento óptimo y listos para la ejecución de inferencias.

El beneficio más importante para el desarrollador es que la plataforma no requiere ninguna configuración de hardware por parte del usuario. El entorno de desarrollo basado en navegador de Jupyter Notebook permite a los desarrolladores ejecutar código desde su navegador y visualizar los resultados al instante. Esto les permite crear prototipos de soluciones de visión por computadora en el entorno de nube de Intel y ver cómo se ejecuta su código en cualquier combinación de sus recursos de hardware disponibles.

Hay tres beneficios principales de esta oferta basada en la nube. Primero, aborda el problema de la parálisis de la elección del hardware. Los desarrolladores pueden ejecutar aplicaciones de IA de forma remota en una amplia gama de hardware para determinar cuál es mejor para su solución en función de factores como el tiempo de ejecución de la inferencia, el consumo de energía y el costo.

En segundo lugar, ofrece acceso remoto inmediato al último hardware Intel Edge. En el lado del software, aborda el problema de tener que lidiar con software desactualizado, ya que brinda acceso instantáneo a la última versión del kit de herramientas Intel Distribution of OpenVINO y hardware de borde compatible.

Y tercero, ofrece acceso a evaluaciones comparativas de rendimiento específicas de la aplicación en un formato paralelo fácil de comparar.

(Aquí encontrará un tutorial sobre la ejecución de modelos de detección de objetos con Intel DevCloud para Edge).

Cree un modelo en la nube, vea lo que sucede en vivo

Otro enfoque es introducir datos en una plataforma en la nube para visualizar y crear modelos de entrenamiento e implementarlos en dispositivos integrados. Edge Impulse hace precisamente eso, ofreciendo un entorno de desarrollo basado en la nube que tiene como objetivo simplificar la adición de aprendizaje automático en dispositivos periféricos sin necesidad de un doctorado. en aprendizaje automático, según la empresa.

Su plataforma permite a los usuarios importar datos de imágenes recopilados en el campo, construir rápidamente clasificadores para interpretar esos datos e implementar modelos en dispositivos de producción de baja potencia. Una clave de la plataforma web Edge Impulse es la capacidad de ver y etiquetar todos los datos adquiridos, crear bloques de preprocesamiento para aumentar y transformar datos, visualizar el conjunto de datos de imágenes y clasificar y validar modelos en datos de entrenamiento directamente desde la interfaz de usuario.

Debido a que puede ser bastante difícil construir un modelo de visión por computadora desde cero, Edge Impulse utiliza un proceso de aprendizaje por transferencia para que sea más fácil y rápido entrenar modelos. Esto implica aprovechar un modelo bien entrenado y reentrenar solo las capas superiores de una red neuronal, lo que lleva a modelos mucho más confiables que se entrenan en una fracción del tiempo y funcionan con conjuntos de datos sustancialmente más pequeños. Con el modelo diseñado, entrenado y verificado, es posible implementar este modelo nuevamente en el dispositivo. Luego, el modelo puede ejecutarse en el dispositivo sin conexión a Internet, con todos sus beneficios inherentes, como minimizar la latencia, y se ejecuta con un consumo de energía mínimo. El modelo completo está empaquetado con pasos de preprocesamiento, pesos de redes neuronales y código de clasificación en una sola biblioteca de C ++ que se puede incluir en el software integrado.

Pasar a un nivel superior de abstracción

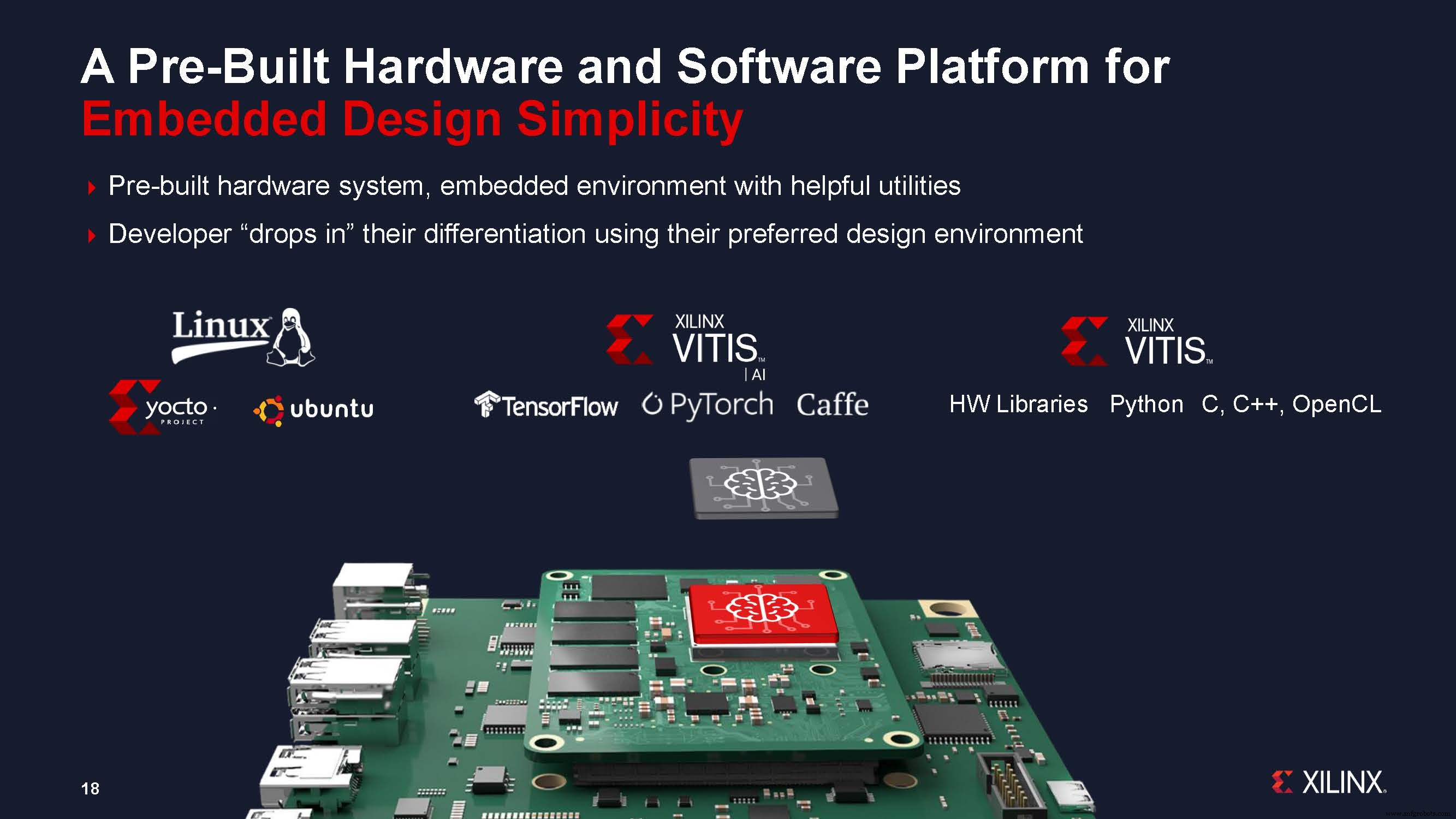

Otro enfoque que ofrecen los proveedores es reducir el tiempo de desarrollo al ofrecer sistemas basados en módulos y permitir el diseño a un mayor nivel de abstracción. Xilinx dijo que su nuevo enfoque de sistemas en módulo (SOM) puede reducir hasta nueve meses el tiempo de desarrollo de los sistemas de visión, al abordar la creciente complejidad en la IA de visión, así como los desafíos para implementar la IA en el borde.

Xilinx anunció recientemente el primer producto de su nueva cartera de SOM:el Kria K26 SOM, dirigido específicamente a aplicaciones de IA de visión en ciudades inteligentes y fábricas inteligentes, junto con un kit de desarrollo de bajo costo listo para usar, el Kria Kit de inicio de visión de IA KV260.

Chetan Khona, director de industria, visión y atención médica de Xilinx, dijo en la rueda de prensa para el lanzamiento de la nueva familia de módulos:“Los sistemas listos para producción son importantes para la implementación rápida [de la IA de visión integrada]. Los clientes pueden ahorrar hasta nueve meses en tiempo de desarrollo mediante el uso de un diseño basado en módulos en lugar de un diseño basado en dispositivos ". Agregó que con el kit de inicio, los usuarios pueden comenzar en una hora, "sin necesidad de experiencia FPGA". Los usuarios conectan la cámara, los cables y el monitor, insertan la tarjeta microSD programada y encienden la placa, y luego pueden seleccionar y ejecutar una aplicación acelerada de su elección.

La cartera de Kria SOM combina la plataforma de hardware y software con aplicaciones de visión acelerada listas para producción. Estas aplicaciones llave en mano eliminan todo el trabajo de diseño de hardware FPGA; Los desarrolladores de software solo necesitan integrar sus modelos personalizados de IA y código de aplicación y, opcionalmente, modificar la canalización de la visión, utilizando entornos de diseño familiares, como los marcos TensorFlow, Pytorch o Café, así como los lenguajes de programación C, C ++, OpenCL y Python.

Los SOM de Kria también permiten la personalización y optimización para desarrolladores integrados con soporte para PetaLinux estándar basado en Yocto. Xilinx dijo que una colaboración con Canonical también está en progreso para brindar soporte a Ubuntu Linux, la distribución de Linux muy popular utilizada por los desarrolladores de IA. Esto ofrece una amplia familiaridad con los desarrolladores de IA e interoperabilidad con las aplicaciones existentes. Los clientes pueden desarrollarse en cualquier entorno y adoptar cualquier enfoque de producción. Ambos entornos vendrán prediseñados con una infraestructura de software y utilidades útiles.

Hemos destacado tres de los enfoques que están adoptando los proveedores para abordar la brecha de habilidades y conocimientos, así como el tiempo de implementación, para el desarrollo de sistemas de visión integrados. Los enfoques basados en la nube ofrecen herramientas que "democratizan" la capacidad de crear y entrenar modelos y evaluar hardware para una implementación extremadamente rápida en dispositivos integrados. Y el enfoque que ofrece un módulo o diseño de referencia con una biblioteca de aplicaciones permite a los desarrolladores de inteligencia artificial utilizar herramientas existentes para crear sistemas de visión integrados rápidamente. Todo esto nos está moviendo a una forma diferente de ver las placas y herramientas de desarrollo. Eliminan el misterio de la visión incorporada al ascender en la cadena de valor, dejando el trabajo de nivel fundamental a las herramientas y módulos de los proveedores.

Contenidos relacionados :

- Visión integrada en el punto de inflexión

- Cinco tendencias a seguir en la visión integrada y la inteligencia artificial perimetral

- ¿Las máquinas comprenderán alguna vez completamente lo que están viendo?

- Xilinx SOM apunta a una adopción más amplia de la inteligencia artificial de vanguardia y la visión integrada

- Embedded Vision Summit:percepción de ML en FPGA diminutas

- GWM adopta el SoC Ambarella AI Vision para el nuevo SUV

- AImotive muestra una eficiencia de visión de borde del 98% en Nextchip Apache5

- La placa de visión de inteligencia artificial de baja potencia dura "años" con una sola batería

- OmniVision encoge el sensor de imagen médica para una endoscopia más profunda

Incrustado

- Inspección por visión artificial:herramientas del oficio

- Aplicaciones de IA en la cadena de suministro global

- Elimine las conjeturas de las decisiones de mantenimiento

- Drew Troyer:La cadena de valor del equipo, Parte 3

- Drew Troyer:La cadena de valor del equipo, Parte 2

- Drew Troyer:La cadena de valor del equipo, Parte 1

- ¿5G cumplirá la visión de 2020?

- Maximización del valor de los datos de IoT

- El valor de la medición analógica

- El potencial de la IA en la cadena de suministro de la atención médica

- Repensar la cadena de suministro como un impulsor de valor