Por qué los datos son la base de la confiabilidad

En la era tecnológica actual, los datos son clave para la toma de decisiones. Este campo de especialidad se conoce como "ciencia de datos". Las empresas pueden aprovechar la tecnología recopilando, analizando y utilizando datos para tomar decisiones informadas.

En la era tecnológica actual, los datos son clave para la toma de decisiones. Este campo de especialidad se conoce como "ciencia de datos". Las empresas pueden aprovechar la tecnología recopilando, analizando y utilizando datos para tomar decisiones informadas.

Un grupo de investigación predice que con la tasa actual de crecimiento de los datos, para el 2025 el tamaño de los datos será de 163 zettabytes. Para comprender mejor este número, considere que un zettabyte equivale a un billón de gigabytes. Esto plantea interrogantes sobre el almacenamiento, la calidad y la gestión de datos.

Este artículo discutirá la importancia de los datos y su uso para realizar estudios de confiabilidad significativos. La definición común de confiabilidad es la probabilidad de que una pieza de equipo, sistema o instalación funcione sin fallas durante un período de tiempo determinado en condiciones operativas específicas. Por lo tanto, los datos históricos y precisos de fallas y su análisis adecuado son fundamentales para cualquier análisis de confiabilidad.

El análisis de datos brinda la oportunidad de examinar grandes cantidades de datos y extraer información útil que luego puede respaldar una mejor toma de decisiones. Esto solo es posible si uno tiene una confianza razonable en los datos, porque los datos deficientes pueden llevar a decisiones incorrectas.

Beneficios del análisis de datos

El análisis de confiabilidad es una forma efectiva de ayudar a la gerencia y a los ingenieros a tomar decisiones técnicas y financieras. Entre otras cosas, el análisis de datos ayuda a optimizar los diseños de proyectos, reducir los costos, predecir la vida útil de los componentes, investigar fallas, evaluar los intervalos de garantía, implementar períodos de inspección efectivos y determinar los indicadores clave de rendimiento (KPI). Los datos precisos son vitales para realizar un estudio de confiabilidad integral.

El filtrado y la recopilación de datos son responsabilidades importantes de cualquier ingeniero de confiabilidad. La recopilación de datos es el método de recopilar y evaluar información sobre variables de interés para establecer un modelo sistemático para responder preguntas de investigación específicas, evaluar hipótesis y estimar y respaldar los resultados.

Por tanto, la recopilación de datos es la fase común de toda investigación. Asegurar una recopilación de datos precisa y honesta es el factor común y el mismo objetivo de estos estudios.

Hay muchas herramientas y técnicas disponibles para procesar datos de manera que sean más precisos y confiables, como eliminar valores atípicos que pueden sesgar los resultados generales del análisis de confiabilidad.

Establecimiento de datos sólidos

En cualquier instalación operativa, los datos precisos y confiables, que incluyen el mantenimiento de activos y registros de fallas, ventanas operativas, etc., pueden proporcionar la base para estudios de ingeniería de confiabilidad. Desafortunadamente, no todas las empresas cuentan con los sistemas, procesos y cultura necesarios para la recopilación y gestión de datos.

Un requisito para establecer una base de datos sólida es garantizar que se recopilen y almacenen todos los puntos de datos significativos. Una base de datos que recopila solo algunos datos importantes puede ofrecer una imagen incompleta y quizás incluso engañosa de las operaciones actuales y las condiciones de los activos.

La utilización de herramientas validadas, que son métodos para recopilar los datos evaluados y confiables, puede ser una práctica útil. Por ejemplo, una gran empresa en Finlandia informó que aproximadamente uno de cada seis informes de mantenimiento cerrados (17.2 por ciento) no incluía un modo de falla.

Además, ninguno de los informes de mantenimiento cerrados registró el número y tipo de repuestos. Estas observaciones sugieren que esta empresa en particular tiene una base de datos limitada que ofrecería solo una perspectiva limitada sobre el historial de fallas y mantenimiento de los equipos, y falta información crítica, como la ubicación de las fallas y su impacto.

Un requisito adicional para un análisis de datos eficaz es la notificación oportuna de los datos. Los departamentos de mantenimiento que informan sus hallazgos semanalmente o incluso mensualmente tienen más probabilidades de perder datos y actividades críticas que aquellas organizaciones que implementan un sistema dinámico que consolida los datos de forma continua.

Otra práctica recomendada es asegurarse de que el sistema de recopilación y almacenamiento de datos defina lo que se considera instancias y valores de datos de alta calidad, con la mayor automatización posible, para promover la coherencia en los informes y la capacidad de búsqueda de bases de datos. Un sistema de informes de mantenimiento que depende de campos de texto abiertos esencialmente convierte el análisis de datos en un proceso manual.

Si bien los campos de texto abiertos tienen un lugar en cualquier base de datos bien diseñada, deben usarse para proporcionar más detalles y aclaraciones.

En cambio, el sistema de recopilación y almacenamiento de datos debe tener celdas separadas para cada punto de datos significativo, utilizando tantos menús desplegables como sea posible para garantizar la coherencia de la descripción y los informes. Los ingenieros de confiabilidad solo podrán realizar estudios extensos de confiabilidad cuando los datos se puedan buscar y se describan consistentemente en todo el sistema.

La definición de los tipos de informes y análisis necesarios de una base de datos determinará los campos de datos que se incluirán. Por lo tanto, el primer paso para obtener datos de alta calidad es definir la pregunta a responder y asegurarse de que los datos recopilados sean apropiados para ese propósito.

Para los estudios de confiabilidad, los campos del sistema de base de datos deben recopilar información de mantenimiento sobre piezas de repuesto, modos de falla, horas de trabajo, hallazgos de inspección importantes, componentes dañados y actividades de rutina. Además, controlar la consistencia de los informes en estos campos a través de menús desplegables integrales permitirá que las aplicaciones de software realicen funciones clave, como calcular el tiempo medio entre fallas (MTBF), disponibilidad y otros KPI de confiabilidad.

Factores de calidad de los datos

Herramientas y tecnología

Hay una gran variedad de herramientas disponibles para cumplir con los objetivos de calidad de los datos, incluidas herramientas para reducir la duplicación, integrar y migrar datos entre plataformas y realizar análisis de datos.

Las herramientas de análisis de datos permiten al usuario extraer significado de los datos, como combinar y categorizar datos para revelar tendencias y patrones. Muchas tecnologías ahora están habilitadas para dispositivos móviles. Estas tecnologías pueden minimizar los errores humanos y del sistema en la recopilación de datos. La adopción de estas nuevas herramientas y tecnologías puede ayudar a mejorar la calidad de los datos.

Personas y procesos

Cada empleado de todos los niveles de las operaciones de la empresa, desde el equipo de mantenimiento hasta el ingeniero y la dirección, debe compartir un entendimiento común del papel de los datos en la empresa. Esto incluye qué datos se recopilarán, con qué frecuencia y con qué fines se utilizarán. Junto con la capacitación, se deben establecer procesos claros para garantizar la recopilación y el almacenamiento de datos confiables y consistentes.

Cultura organizacional

El apoyo a la gestión y la cultura de la empresa juegan un papel vital en la calidad de los datos. Los KPI informados a la gerencia deben monitorear la calidad de los datos. Si una organización desea lanzar un nuevo proyecto o iniciativa para mejorar el desempeño, aumentar la cantidad de oportunidades o abordar problemas importantes, a menudo debe realizar cambios, incluidos cambios en los procesos, roles de trabajo, estructuras y tipos organizacionales, y el uso de tecnología. .

Los procedimientos y procesos de trabajo deben actualizarse y alinearse con las mejores prácticas. La mejora continua será el motor del éxito. La calidad y cantidad de datos será clave para este controlador. A través de la capacitación continua, se puede desarrollar la importancia de los datos entre el personal, lo que ayudará a mejorar la cultura organizacional.

Impacto de los datos en la confiabilidad

Para obtener una ilustración de la importancia de la calidad de los datos, considere el siguiente estudio de caso. Una instalación lanzó un proyecto para aumentar la producción de petróleo mediante la instalación de un nuevo paquete de separación de gas y petróleo (GOSP) con unidades de estabilización de crudo. Los GOSP estarían compuestos por trampas de separación, instalaciones de manejo de crudo húmedo, un separador de aceite de agua, instalaciones de compresión de gas, un sistema de antorcha, bombas de transferencia / envío e instalaciones de estabilización.

Se realizó un estudio de confiabilidad, disponibilidad y mantenibilidad (RAM) para predecir la disponibilidad de producción de las instalaciones y compararla con la disponibilidad objetivo. El estudio también se utilizaría para identificar áreas que limitan el rendimiento de la producción, recomendar medidas para lograr la disponibilidad necesaria para cumplir con los objetivos comerciales de producción, confirmar las filosofías de operación y mantenimiento adoptadas para cumplir con la disponibilidad total del sistema y definir acciones correctivas o posibles cambios de diseño. .

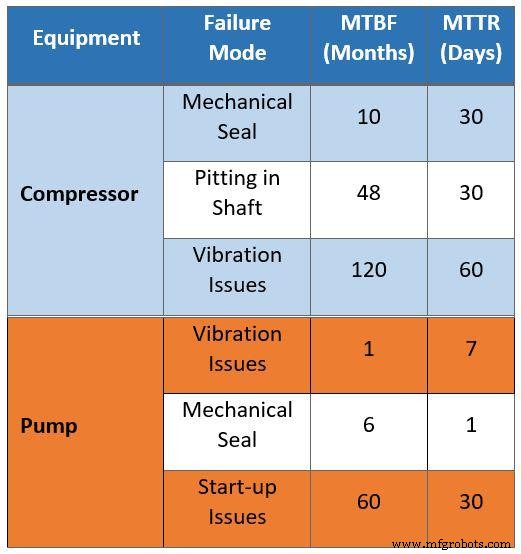

Los datos brutos de mantenimiento se resumen en la Tabla 1. Se basan en entrevistas con los equipos de mantenimiento de las instalaciones operativas existentes. Los datos recopilados para el estudio tenían problemas en varias áreas, comenzando con la comparación falsa de los datos de mantenimiento de los activos antiguos para determinar los límites operativos de la nueva instalación.

Por ejemplo, la Tabla 1 sugiere que cada 10 meses un compresor estará fuera de servicio durante 30 días debido a problemas con los sellos mecánicos. Esta estimación asume que un compresor pasará el 10 por ciento de su vida útil en mantenimiento debido a problemas con los sellos mecánicos. Esta suposición es incorrecta ya que la instalación adoptará nuevas tecnologías. Además, muchas lecciones aprendidas de las instalaciones más antiguas se reflejarán en el nuevo diseño.

Otra suposición incorrecta extraída de los datos es el impacto de la corrosión. Los datos brutos parecen sugerir que el compresor se mantiene en mantenimiento durante 30 días cada cuatro años (48 meses) como resultado de picaduras en el eje. El uso de material mejorado en el eje del compresor eliminará este tipo de problemas.

La Tabla 1 indica además que el tiempo medio de reparación (MTTR) debido a la vibración es de 60 días. Compare esta suposición con el MTTR promedio esperado para compresores nuevos de solo cuatro días debido a la mejor gestión de piezas de repuesto.

Como ilustra este ejemplo, las suposiciones extraídas de datos que pueden ser precisos para instalaciones antiguas con equipos antiguos no son precisas cuando se aplican a instalaciones nuevas diseñadas con materiales mejorados y tecnologías más eficientes.

Tabla 1. Datos de campo sin procesar recopilados para un estudio de confiabilidad, disponibilidad y mantenibilidad

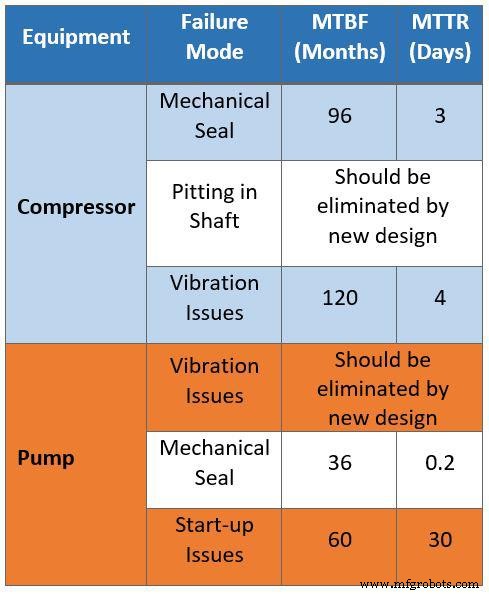

La Tabla 2 resume el mismo conjunto de datos corregido por ingenieros de confiabilidad. Al acceder a los mismos datos proporcionados al proveedor externo, los ingenieros filtraron los datos sin procesar para eliminar todos los problemas de mantenimiento que podrían corregirse automáticamente mediante la instrumentación del proceso. Luego, los datos se clasificaron mediante estrategias de gestión operativa y de mantenimiento para identificar problemas relacionados con fallas de diseño, como cuellos de botella, capacidad limitada y disponibilidad.

Los datos corregidos se pueden aplicar a la nueva instalación y usarse para tomar decisiones para la optimización del diseño. Por ejemplo, los modos de falla para compresores de gas ahora muestran un MTBF de ocho años debido a sellos secos y un MTTR de tres días. Además, los supuestos de corrosión para los compresores de eje se eliminaron mediante materiales mejorados en el nuevo diseño de la instalación.

Tabla 2. Datos filtrados recopilados para el estudio de confiabilidad, disponibilidad y mantenibilidad

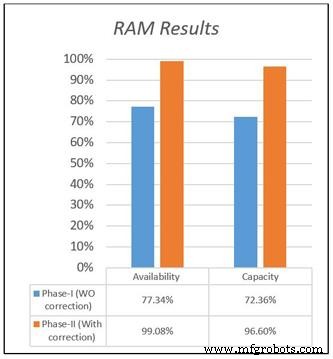

La disponibilidad y capacidad para ambos diseños se representan en la Figura 1. Esto ilustra la diferencia en los resultados entre los dos modelos según los conjuntos de datos proporcionados, así como la diferencia en los resultados de disponibilidad y capacidad. Los datos originales sitúan la disponibilidad de la nueva instalación en 77,34 por ciento debido a un MTTR largo y un MTBF corto, mientras que el conjunto de datos corregidos calculó la disponibilidad general en 99 por ciento, que representa la situación real.

En el mismo proyecto, se realizó una práctica similar para el resto de equipos. Se le pidió al equipo de gestión del proyecto (PMT) que eliminara el equipo de repuesto debido a la alta disponibilidad. Los resultados se utilizaron para optimizar la configuración del diseño para la utilización completa del sistema. Como ilustra este estudio de caso, el empleo de datos corregidos puede tener un gran impacto en los costos de capital y construcción de nuevos proyectos al eliminar equipos innecesarios y acelerar el tiempo de finalización del proyecto y evitar costos.

Figura 1. Resultados del estudio de confiabilidad, disponibilidad y mantenibilidad (RAM)

Figura 2. La relación entre los datos de entrada, el diseño y los resultados del simulador

Los resultados significativos para cualquier software o simulador de confiabilidad dependen de la calidad de los datos de entrada y el diseño. Como dice el refrán, "basura entra, basura sale". La Figura 2 muestra la relación entre el diseño y los datos de entrada con los resultados de la simulación de RAM. Una vez que el modelo de RAM se construye en base a los datos de entrada, se puede introducir una optimización potencial. Los datos son el elemento clave en el modelo y otras medidas de desempeño de confiabilidad.

Lo mismo es cierto para los estudios de confiabilidad enfocados. Los ingenieros de confiabilidad dedican gran parte de su tiempo a analizar datos en las operaciones. Por ejemplo, los ingenieros pueden realizar un estudio de confiabilidad sobre elementos específicos que actúan mal, que se definen como un componente, equipo o sistema con altos costos de mantenimiento y altas tasas de fallas.

Los resultados de esta evaluación se utilizan para concentrar los recursos limitados en elementos de alto impacto con el mayor beneficio para las operaciones de campo en términos de costos de mantenimiento y disponibilidad. Si los ingenieros tienen datos no representativos o no tienen suficientes datos, todos los resultados y recomendaciones no abordarán los problemas reales.

Esto representa una oportunidad perdida para agregar valor a la planificación del mantenimiento, la gestión de piezas de repuesto, el presupuesto de mantenimiento y los desafíos técnicos. Por lo tanto, los datos de calidad requieren sistemas de recopilación de datos eficientes que identifiquen claramente los tipos y la cantidad de datos necesarios para respaldar las decisiones que debe tomar la organización.

Tres pasos clave para mejorar la calidad de los datos

1. Implemente la plataforma de base de datos adecuada

La solución seleccionada para la organización no debe cerrar ninguna notificación de mantenimiento ni órdenes de trabajo hasta que se completen todos los campos obligatorios. En otras palabras, la plataforma seleccionada debe deshabilitar los accesos directos para garantizar la coherencia de los datos recopilados.

2. Integre funciones existentes en una solución integral

La plataforma debe incorporar todas las funciones de confiabilidad en una solución para integrar mejor los datos y reducir la cantidad de sistemas implementados en una organización. Por ejemplo, si se sacaron piezas de repuesto del almacén, se deben cargar con una notificación específica. Esto requeriría una plataforma que asimile la gestión de repuestos con las actividades de mantenimiento.

3. Implementar un programa de garantía de calidad de los datos

Las actividades de garantía de calidad para la solución implementada deben incluir una auditoría periódica de la calidad de los datos en toda la organización. Por ejemplo, el equipo de control de calidad podría auditar al azar el 5 por ciento de las notificaciones de mantenimiento y las órdenes de trabajo para cada instalación operativa para evaluar la calidad de los datos recopilados. Los resultados de esta evaluación podrían utilizarse para mejorar aún más la utilización de la solución y garantizar una base de datos eficaz.

Los datos son la piedra angular

Los datos completos del historial de reparaciones y mantenimiento de activos deben recopilarse, almacenarse y analizarse correctamente. Los empleados de primera línea, incluidos los equipos de mantenimiento y el personal de operaciones que participan en la recopilación de datos, también deben comprender la importancia de su papel en la calidad de los datos.

Recuerde, los datos son la piedra angular para la toma de decisiones en cualquier empresa y la calidad de los datos está en el centro de todos los estudios de confiabilidad. Si tiene datos de alta calidad, puede utilizarlos con confianza para una promoción eficaz, una investigación significativa, una planificación estratégica y una gestión.

Acerca de los autores

Khalid A. Al-Jabr es un especialista en ingeniería de confiabilidad para Saudi Aramco que tiene más de 18 años de experiencia industrial con un enfoque en la confiabilidad y los desafíos de los equipos. Tiene un doctorado, es un ingeniero colegiado y está certificado como profesional en gestión de ingeniería y análisis de datos.

Qadeer Ahmed trabaja como ingeniero consultor de confiabilidad para Saudi Aramco y tiene 18 años de experiencia en ingeniería de confiabilidad. Ingeniero colegiado, tiene un doctorado. y es un profesional certificado en mantenimiento y confiabilidad (CMRP) y un cinturón negro Six Sigma.

Dahham Al-Anazi es líder en ingeniería de confiabilidad del departamento de servicios de consultoría de Saudi Aramco. Tiene más de 25 años de experiencia técnica y es doctor en ingeniería mecánica.

Tecnología de Internet de las cosas

- Datos para todos:¿Democratizar los datos de los pacientes es el futuro?

- Por qué el futuro de la seguridad de los datos en la nube es programable

- ¡¿Qué hago con los datos ?!

- Por qué la excelencia en confiabilidad es imperativa para la seguridad

- Perspectivas para el desarrollo de IoT industrial

- El potencial para integrar datos visuales con IoT

- Por qué Internet de las cosas necesita inteligencia artificial

- Preparando el escenario para el éxito de la ciencia de datos industriales

- Las tendencias continúan impulsando el procesamiento al límite para la IA

- Por qué la automatización es el único camino a seguir para la fabricación

- DataOps:el futuro de la automatización del cuidado de la salud