El informe ETSI allana el camino para estandarizar la seguridad de la IA

Un nuevo informe de ETSI, la organización europea de estándares para redes y servicios de telecomunicaciones, radiodifusión y comunicaciones electrónicas, tiene como objetivo allanar el camino para establecer un estándar para la seguridad de la inteligencia artificial (IA).

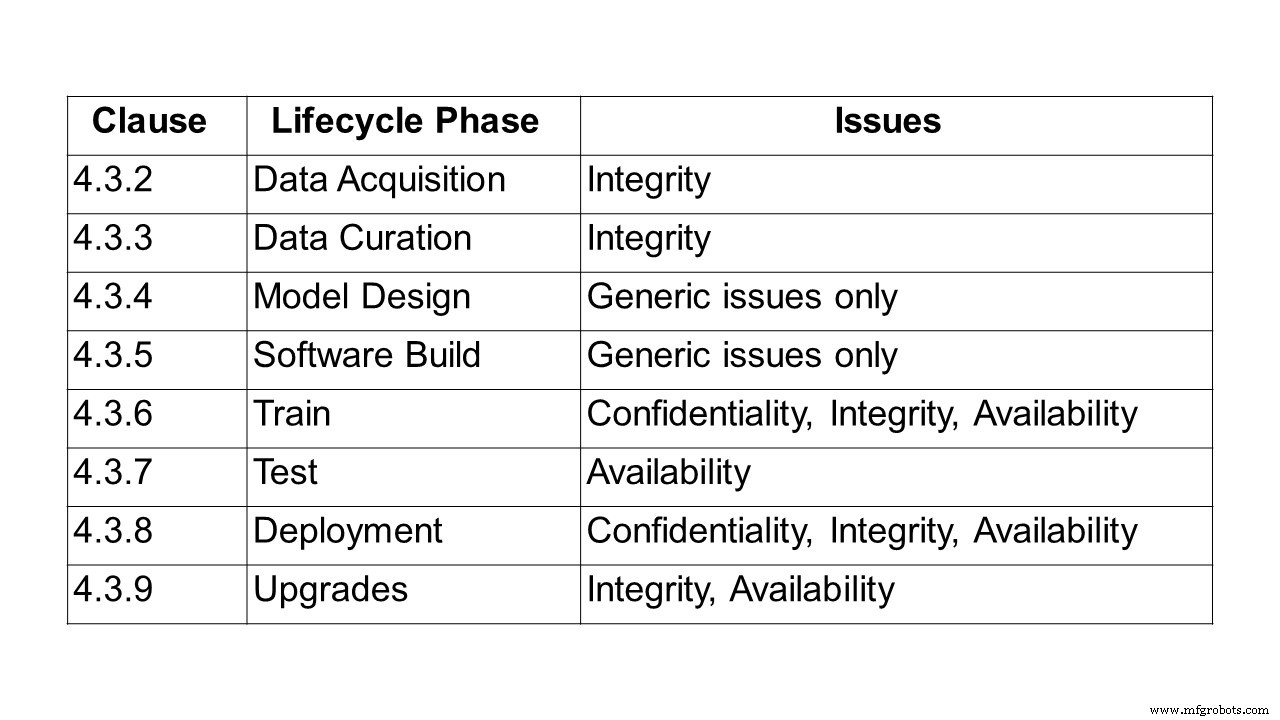

El primer paso en el camino hacia la creación de un estándar es describir el problema de proteger los sistemas y soluciones basados en IA. Esto es lo que hace el informe de 24 páginas, ETSI GR SAI 004, el primero en ser publicado por ETSI Securing Artificial Intelligence Industry Specification Group (SAI ISG). Define la declaración del problema y tiene un enfoque particular en el aprendizaje automático (ML) y los desafíos relacionados con la confidencialidad, la integridad y la disponibilidad en cada etapa del ciclo de vida del aprendizaje automático. También señala algunos de los desafíos más amplios de los sistemas de inteligencia artificial, incluidos el sesgo, la ética y la capacidad de explicación. Se describen varios vectores de ataque diferentes, así como varios casos de uso y ataques en el mundo real.

Para identificar los problemas relacionados con la seguridad de la IA, el primer paso fue definir la IA. Para el grupo ETSI, la inteligencia artificial es la capacidad de un sistema para manejar representaciones, tanto explícitas como implícitas, y procedimientos para realizar tareas que se considerarían inteligentes si las realizara un humano. Esta definición todavía representa un amplio espectro de posibilidades. Sin embargo, un conjunto limitado de tecnologías se está volviendo factible, en gran parte impulsado por la evolución del aprendizaje automático y las técnicas de aprendizaje profundo, y la amplia disponibilidad de los datos y el poder de procesamiento necesarios para entrenar e implementar tales tecnologías.

Numerosos enfoques para el aprendizaje automático son de uso común, incluido el aprendizaje supervisado, no supervisado, semisupervisado y por refuerzo.

- Aprendizaje supervisado:donde todos los datos de entrenamiento están etiquetados y el modelo se puede entrenar para predecir el resultado en función de un nuevo conjunto de entradas.

- Aprendizaje semi-supervisado:donde el conjunto de datos está parcialmente etiquetado. En este caso, incluso los datos sin etiquetar se pueden utilizar para mejorar la calidad del modelo.

- Aprendizaje no supervisado:donde el conjunto de datos no está etiquetado y el modelo busca estructura en los datos, incluida la agrupación y la agrupación en clústeres.

- Aprendizaje por refuerzo:donde los agentes aprenden una política que define cómo actuar a través de la experiencia para maximizar su recompensa; y los agentes adquieren experiencia al interactuar en un entorno a través de transiciones de estado.

Dentro de estos paradigmas, se pueden utilizar una variedad de estructuras modelo, siendo uno de los enfoques más comunes el uso de redes neuronales profundas, donde el aprendizaje se lleva a cabo sobre una serie de capas jerárquicas que imitan el comportamiento del cerebro humano.

También se pueden usar varias técnicas de entrenamiento, a saber, aprendizaje contradictorio, donde el conjunto de entrenamiento contiene no solo muestras que reflejan los resultados deseados, sino también muestras contradictorias, que están destinadas a desafiar o interrumpir el comportamiento esperado.

“Hay muchas discusiones sobre la ética de la IA, pero ninguna sobre los estándares para asegurar la IA. Sin embargo, se están volviendo fundamentales para garantizar la seguridad de las redes automatizadas basadas en inteligencia artificial. Este primer informe de ETSI está destinado a ofrecer una definición completa de los desafíos que se enfrentan al proteger la IA. Paralelamente, estamos trabajando en una ontología de amenazas, en cómo asegurar una cadena de suministro de datos de IA y cómo probarla ”, explica Alex Leadbeater, presidente de ETSI SAI ISG.

Cuando se le preguntó acerca de los plazos, Leadbeater dijo a embedded.com:“Otros 12 meses es una estimación razonable para las especificaciones técnicas. Habrá más informes técnicos en los próximos dos trimestres (Ontología de amenazas de IA, Informe de cadena de suministro de datos, Informe de estrategia de mitigación de SAI). De hecho, una especificación sobre las pruebas de seguridad de la IA debería estar disponible antes, hacia el final del segundo trimestre / tercer trimestre. Los próximos pasos serán identificar áreas específicas en el enunciado del problema que se pueden expandir en elementos de trabajo informativos más detallados ”.

Resumen del informe

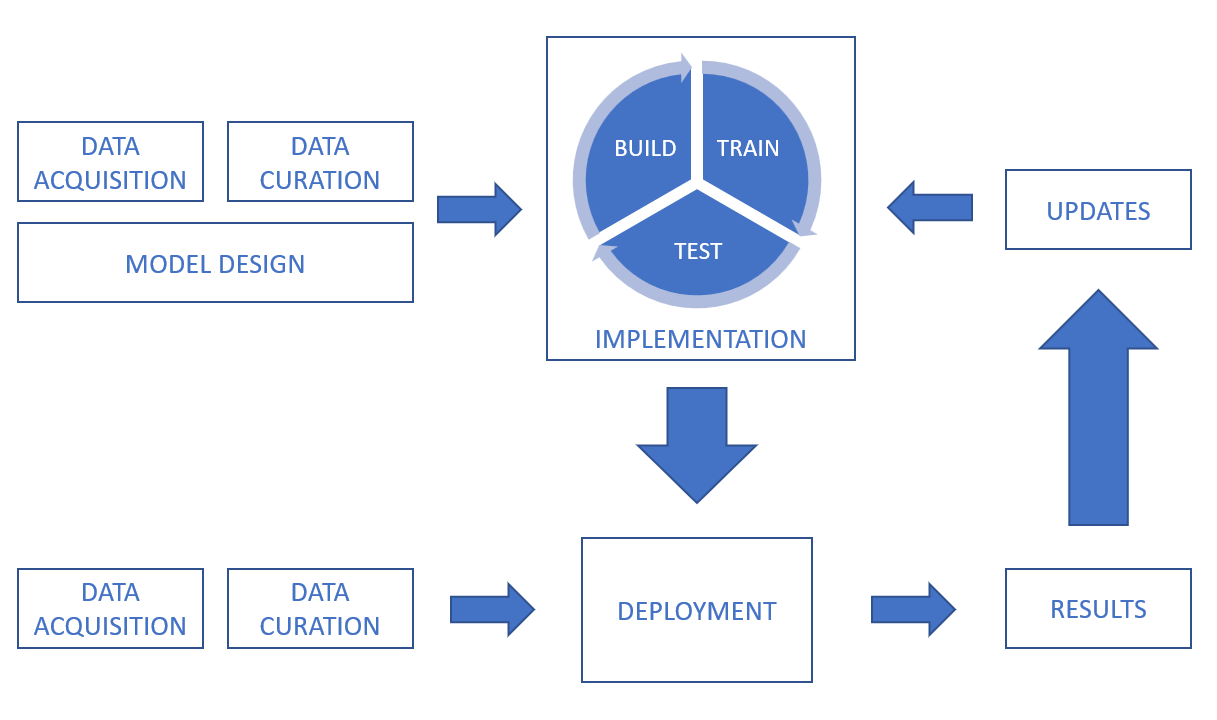

Siguiendo la definición de IA y aprendizaje automático, el informe analiza la cadena de procesamiento de datos, cubriendo los desafíos de confidencialidad, integridad y disponibilidad a lo largo del ciclo de vida, desde la adquisición de datos, la curación de datos, el diseño de modelos y la construcción de software, hasta la capacitación, las pruebas, la implementación y inferencia y actualizaciones.

En un sistema de inteligencia artificial, los datos se pueden obtener de una multitud de fuentes, incluidos sensores (como cámaras CCTV, teléfonos móviles, dispositivos médicos) y activos digitales (como datos de plataformas comerciales, extractos de documentos, archivos de registro). Los datos también pueden estar en muchas formas diferentes (incluidos texto, imágenes, video y audio) y pueden estar estructurados o no estructurados. Además de los desafíos de seguridad relacionados con los datos en sí, es importante considerar la seguridad de la transmisión y el almacenamiento.

Para dar una indicación de los desafíos de integridad en la conservación de datos, al reparar, aumentar o convertir conjuntos de datos, es importante asegurarse de que los procesos no corran el riesgo de afectar la calidad e integridad de los datos. Para los sistemas de aprendizaje automático supervisados, es importante que el etiquetado de datos sea preciso y lo más completo posible, y garantizar que el etiquetado conserve su integridad y no se vea comprometido, por ejemplo, a través de ataques de envenenamiento. También es importante abordar el desafío de garantizar que el conjunto de datos sea imparcial. Las técnicas para el aumento de datos pueden afectar la integridad de los datos.

Otra área cubierta es alrededor de los desafíos de diseño y otros factores no intencionales relacionados con el sesgo, la ética de los datos y la explicabilidad.

Por ejemplo, el sesgo debe considerarse no solo durante las fases de diseño y capacitación, sino también después de que se haya implementado un sistema, ya que aún podría introducirse sesgo. El informe cita un ejemplo de 2016, cuando se lanzó un chatbot, que pretendía ser un experimento de "comprensión conversacional". El chatbot interactuaría con los usuarios de las redes sociales a través de tweets y mensajes directos. En cuestión de horas, el chatbot estaba comenzando a tuitear mensajes altamente ofensivos. Después de que se retiró el chatbot, se descubrió que la cuenta del chatbot había sido manipulada para mostrar un comportamiento sesgado por parte de los trolls de Internet. El sesgo no representa necesariamente un problema de seguridad, sino que simplemente puede hacer que el sistema no cumpla con sus requisitos funcionales.

Sobre la ética, el informe destaca varios ejemplos, incluidos los automóviles autónomos y la atención médica. Cita un documento de la Universidad de Brighton que discutió un escenario hipotético en el que un automóvil impulsado por IA atropella a un peatón y explora las responsabilidades legales que surgen. En marzo de 2018, este escenario se hizo realidad cuando un automóvil autónomo atropelló y mató a un peatón en la ciudad de Tempe, Arizona. Esto puso de relieve no solo las responsabilidades legales, sino los posibles desafíos éticos del proceso de toma de decisiones en sí. En 2016, el Instituto de Tecnología de Massachusetts (MIT) lanzó un sitio web llamado Moral Machine que explora los desafíos de permitir que los sistemas inteligentes tomen decisiones de naturaleza ética. El sitio intenta explorar cómo se comportan los humanos cuando se enfrentan a dilemas éticos y obtener una mejor comprensión de cómo deben comportarse las máquinas.

El informe enfatiza que si bien las preocupaciones éticas no tienen una relación directa con las características de seguridad tradicionales de confidencialidad, integridad y disponibilidad, pueden tener un efecto significativo en la percepción de una persona de si se puede confiar en un sistema. Por lo tanto, es esencial que los diseñadores e implementadores de sistemas de IA consideren los desafíos éticos y busquen crear sistemas éticos sólidos que puedan generar confianza entre los usuarios.

Finalmente, el informe analiza los tipos de ataques, desde envenenamiento y ataques de puerta trasera hasta ingeniería inversa, seguidos de casos de uso y ataques del mundo real.

En un ataque de envenenamiento, un atacante busca comprometer el modelo de IA, normalmente durante la fase de entrenamiento, para que el modelo desplegado se comporte de la manera que el atacante desea. Esto puede deberse a que el modelo falla en función de ciertas tareas o entradas, o que el modelo aprende un conjunto de comportamientos que son deseables para el atacante, pero no previstos por el diseñador del modelo. Los ataques de envenenamiento generalmente pueden ocurrir de tres maneras:

- Envenenamiento de datos - en el que el atacante introduce datos incorrectos o etiquetados incorrectamente en el conjunto de datos durante las fases de recopilación o conservación de datos.

- Envenenamiento por algoritmos - cuando un atacante interfiere con los algoritmos utilizados para el proceso de aprendizaje. Por ejemplo, el aprendizaje federado implica entrenar modelos individuales en subconjuntos de datos y luego combinar los modelos aprendidos para formar el modelo final. Esto significa que los conjuntos de datos individuales permanecen privados, pero crea una vulnerabilidad inherente. Dado que un atacante podría controlar cualquier conjunto de datos individuales, podría manipular esa parte del modelo de aprendizaje directamente e influir en el aprendizaje general del sistema.

- Modelo de envenenamiento - cuando todo el modelo desplegado simplemente se reemplaza por un modelo alternativo. Este tipo de ataque es similar a un ciberataque tradicional donde los archivos electrónicos que componen el modelo podrían ser alterados o reemplazados.

Si bien el término "inteligencia artificial" se originó en una conferencia en la década de 1950 en Dartmouth College en Hanover, New Hampshire, EE. UU., Los casos de uso en la vida real descritos en el informe ETSI muestran cuánto ha evolucionado desde entonces. Tales casos incluyen ataques de bloqueadores de anuncios, ofuscación de malware, deepfakes, reproducción de escritura a mano, voz humana y conversación falsa (que ya ha generado muchos comentarios con los chatbots).

¿Qué sigue? Informes en curso como parte de este ISG

Este grupo de especificaciones de la industria (ISG) está analizando varios informes en curso como parte de los elementos de trabajo en los que profundizará.

Pruebas de seguridad :El propósito de este elemento de trabajo es identificar objetivos, métodos y técnicas que sean apropiados para las pruebas de seguridad de componentes basados en IA. El objetivo general es tener directrices para las pruebas de seguridad de IA y componentes basados en IA teniendo en cuenta los diferentes algoritmos de IA simbólica y subsimbólica y abordar las amenazas relevantes del elemento de trabajo "Ontología de amenazas de IA". Las pruebas de seguridad de la IA tienen algunos puntos en común con las pruebas de seguridad de los sistemas tradicionales, pero ofrecen nuevos desafíos y requieren diferentes enfoques, debido a

(a) diferencias significativas entre la IA simbólica y subsimbólica y los sistemas tradicionales que tienen fuertes implicaciones en su seguridad y en cómo probar sus propiedades de seguridad;

(b) no determinismo, ya que los sistemas basados en IA pueden evolucionar con el tiempo (sistemas de autoaprendizaje) y las propiedades de seguridad pueden degradarse;

(c) problema de prueba de Oracle, asignar un veredicto de prueba es diferente y más difícil para los sistemas basados en IA ya que no todos los resultados esperados se conocen a priori, y (d) algoritmos basados en datos:a diferencia de los sistemas tradicionales, (entrenamiento) datos forma el comportamiento de la IA subsimbólica.

El alcance de este elemento de trabajo sobre pruebas de seguridad es cubrir los siguientes temas (pero no limitado a):

- enfoques de pruebas de seguridad para IA

- probar datos para IA desde un punto de vista de seguridad

- oráculos de prueba de seguridad para IA

- definición de los criterios de adecuación de las pruebas para las pruebas de seguridad de la IA

- objetivos de prueba para los atributos de seguridad de la IA

Y proporciona pautas para las pruebas de seguridad de la IA teniendo en cuenta los temas mencionados anteriormente. Las pautas utilizarán los resultados del elemento de trabajo "Ontología de amenazas de IA" para cubrir las amenazas relevantes para la IA a través de pruebas de seguridad y también abordarán los desafíos y limitaciones al probar el sistema basado en IA.

Ontología de amenazas de IA :El propósito de este elemento de trabajo es definir qué se consideraría una amenaza de IA y cómo podría diferir de las amenazas a los sistemas tradicionales. El punto de partida que ofrece la justificación de este trabajo es que, actualmente, no existe un entendimiento común de lo que constituye un ataque a la IA y cómo podría crearse, hospedarse y propagarse. El producto entregable del elemento de trabajo “Ontología de amenazas de IA” buscará alinear la terminología entre las diferentes partes interesadas y las múltiples industrias. Este documento definirá lo que se entiende por estos términos en el contexto de la seguridad física y cibernética y con una narrativa adjunta que debe ser fácilmente accesible tanto para los expertos como para las audiencias menos informadas en las múltiples industrias. Tenga en cuenta que esta ontología de amenazas abordará la IA como sistema, un atacante adversario y un defensor del sistema.

Informe de la cadena de suministro de datos :Los datos son un componente crítico en el desarrollo de sistemas de IA. Esto incluye datos sin procesar, así como información y comentarios de otros sistemas y humanos en el circuito, todo lo cual se puede usar para cambiar la función del sistema entrenando y volviendo a capacitar a la IA. Sin embargo, el acceso a datos adecuados suele ser limitado, lo que genera la necesidad de recurrir a fuentes de datos menos adecuadas. Se ha demostrado que comprometer la integridad de los datos de entrenamiento es un vector de ataque viable contra un sistema de IA. Esto significa que asegurar la cadena de suministro de los datos es un paso importante para asegurar la IA. Este informe resumirá los métodos que se utilizan actualmente para obtener datos para entrenar la IA junto con las regulaciones, estándares y protocolos que pueden controlar el manejo y el intercambio de esos datos. Luego, proporcionará un análisis de brechas en esta información para determinar los posibles requisitos de los estándares para garantizar la trazabilidad y la integridad de los datos, los atributos asociados, la información y la retroalimentación, así como la confidencialidad de estos.

Estrategia de mitigación de EFS Informe:Este elemento de trabajo tiene como objetivo resumir y analizar la mitigación existente y potencial contra las amenazas para los sistemas basados en IA. El objetivo es tener pautas para mitigar las amenazas introducidas mediante la adopción de IA en los sistemas. Estas pautas arrojarán luz sobre la seguridad de los sistemas basados en inteligencia artificial al mitigar las amenazas de seguridad conocidas o potenciales. También abordan las capacidades de seguridad, los desafíos y las limitaciones al adoptar la mitigación para los sistemas basados en IA en ciertos casos de uso potenciales.

? El papel del hardware en la seguridad de la IA: Elaborar un informe que identifique el papel del hardware, tanto especializado como de propósito general, en la seguridad de la IA. Esto abordará las mitigaciones disponibles en el hardware para prevenir ataques y también abordará los requisitos generales del hardware para respaldar a SAI. Además, este informe abordará las posibles estrategias para utilizar la IA para la protección del hardware. El informe también proporcionará un resumen de la experiencia académica e industrial en seguridad de hardware para IA. Además, el informe abordará las vulnerabilidades o debilidades introducidas por el hardware que pueden amplificar los vectores de ataque en la IA.

El informe completo de ETSI que define la declaración del problema para proteger la IA está disponible aquí.

Tecnología de Internet de las cosas

- Tendencias y consejos de seguridad de IIoT para 2020

- Una receta para la seguridad industrial:una pizca de TI, una pizca de OT y una pizca de SOC

- La búsqueda de un estándar de seguridad de IoT universal

- TI:La tecnología de resonador BAW allana el camino para las comunicaciones de próxima generación

- Guía de seguridad cibernética emitida para usuarios empresariales en la nube

- El informe pide una acción urgente para enfrentar las amenazas cibernéticas a la infraestructura crítica

- Tres pasos para la seguridad global de IoT

- Una guía de cuatro pasos para garantizar la seguridad de los dispositivos Iot

- Qué significa la llegada de 5G para la seguridad de IoT

- La penalización por reclamaciones "Made in USA" de la FTC allana el camino para una aplicación adicional

- El informe sobre el estado de los activos cibernéticos sigue encontrando vulnerabilidades