PyTorch vs TensorFlow:comparación en profundidad

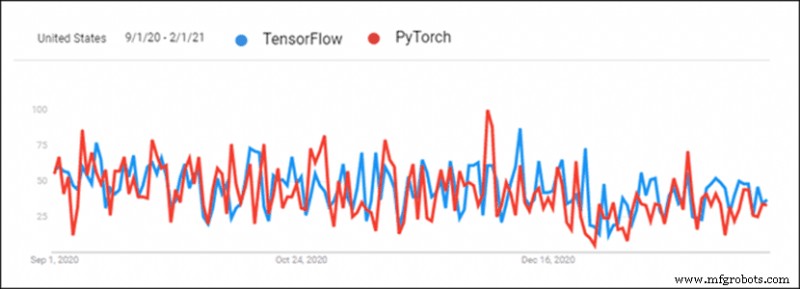

La creciente popularidad del aprendizaje profundo creó una sana competencia entre los marcos de aprendizaje profundo. PyTorch y TensorFlow se destacan como dos de los marcos de aprendizaje profundo más populares. Las bibliotecas están compitiendo cara a cara por tomar la delantera y convertirse en la principal herramienta de aprendizaje profundo.

TensorFlow es más antiguo y siempre tuvo la delantera debido a esto, pero PyTorch se puso al día en los últimos seis meses. Hay mucha confusión acerca de tomar la decisión correcta al elegir un marco de aprendizaje profundo para un proyecto.

Este artículo compara PyTorch con TensorFlow y proporciona una comparación detallada de los dos marcos.

PyTorch frente a TensorFlow:descripción general

Tanto PyTorch como TensorFlow realizan un seguimiento de lo que hace su competencia. Sin embargo, todavía hay algunas diferencias entre los dos marcos.

| Biblioteca | PyTorch | TensorFlow 2.0 |

|---|---|---|

| Creado por | FAIR Lab (Laboratorio de investigación de IA de Facebook) | Equipo de cerebro de Google |

| Basado en | Antorcha | Teano |

| Producción | Enfocado en la investigación | Enfocado en la industria |

| Visualización | Visualidad | Tablero de tensor |

| Implementación | Servicio de antorcha (experimental) | Servicio de TensorFlow |

| Implementación móvil | Sí (experimental) | Sí |

| Administración de dispositivos | CUDA | Automatizado |

| Generación de gráficos | Modo dinámico y estático | Modo impaciente y estático |

| Curva de aprendizaje | Más fácil para desarrolladores y científicos | Más fácil para proyectos de nivel industrial |

| T casos | Facebook CheXNet tesla Piloto automático Uber PYRO | Google Sinovación empresas Paypal Móvil de China |

1. Visualización

La visualización hecha a mano lleva tiempo. PyTorch y TensorFlow tienen herramientas para un análisis visual rápido. Esto facilita la revisión del proceso de capacitación. La visualización también es excelente para presentar resultados.

TensorFlow

Tensorboard se utiliza para visualizar datos. La interfaz es interactiva y visualmente atractiva. Tensorboard proporciona una descripción detallada de las métricas y los datos de entrenamiento. Los datos se exportan fácilmente y se ven muy bien para fines de presentación. Los complementos también hacen que Tensorboard esté disponible para PyTorch.

Sin embargo, Tensorboard es engorroso y complicado de usar.

PyTorch

PyTorch usa Visdom para la visualización. La interfaz es ligera y fácil de usar. Visdom es flexible y personalizable. La compatibilidad directa con los tensores de PyTorch facilita su uso.

Visdom carece de interactividad y de muchas características esenciales para la visualización de datos.

2. Generación de gráficos

Hay dos tipos de generación de arquitectura de red neuronal:

- Gráficos estáticos – Arquitectura de capa fija. El mapa se genera primero, luego los datos se envían a través de él.

- Gráficos dinámicos – Arquitectura de capa dinámica. El mapa se define implícitamente con sobrecarga de datos.

TensorFlow

TensorFlow usó gráficos estáticos desde el principio. Los gráficos estáticos permiten la distribución en varias máquinas. Los modelos se implementan independientemente del código. El uso de gráficos estáticos hizo que TensorFlow fuera más amigable con la producción y más flexible al trabajar con nuevas arquitecturas.

TensorFlow agregó una función que imita los gráficos dinámicos llamada ejecución entusiasta. TensorFlow 2 se ejecuta con entusiasmo de forma predeterminada. La generación de gráficos estáticos está disponible cuando se desactiva la ejecución ansiosa.

PyTorch

PyTorch presentó gráficos dinámicos desde el principio. Esta función puso a PyTorch en competencia con TensorFlow.

La capacidad de cambiar gráficos sobre la marcha demostró ser un enfoque más fácil para programadores e investigadores para la generación de redes neuronales. Los datos estructurados y las variaciones de tamaño en los datos son más fáciles de manejar con gráficos dinámicos. PyTorch también proporciona gráficos estáticos.

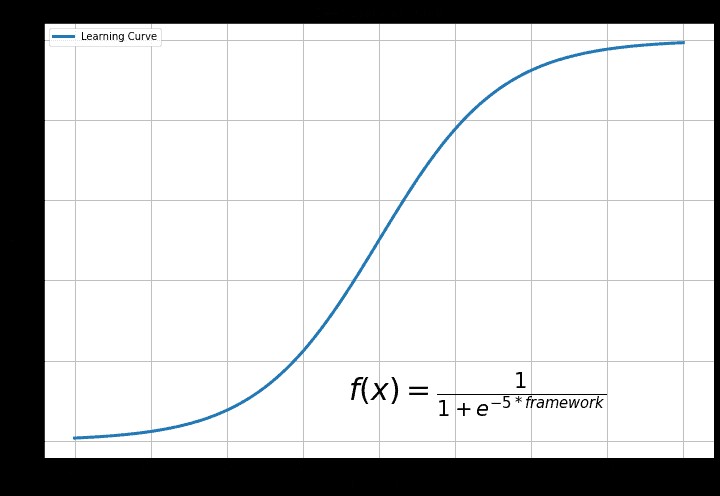

3. Curva de aprendizaje

La curva de aprendizaje depende de la experiencia previa y del objetivo final de utilizar el aprendizaje profundo.

TensorFlow

TensorFlow es la biblioteca más desafiante. Las funciones de Keras hacen que TensorFlow sea más fácil de usar. Por lo general, TensorFlow es difícil de comprender para alguien que recién comienza con el aprendizaje profundo.

La razón detrás de esto es la diversa funcionalidad de TensorFlow. Hay muchas características para explorar y descubrir. Esto distrae y es redundante para un principiante.

PyTorch

PyTorch es la biblioteca más fácil de aprender. Es más fácil experimentar con el código si Python está familiarizado. Existe un enfoque Pythonic para crear una red neuronal en PyTorch. La flexibilidad que tiene PyTorch significa que el código es fácil de experimentar.

PyTorch no tiene tantas funciones, pero todas las funciones esenciales están disponibles. PyTorch es más sencillo para empezar y aprender.

4. Despliegue

La implementación es un paso de desarrollo de software que es importante para los equipos de desarrollo de software. La implementación de software hace que un programa o aplicación esté disponible para el uso del consumidor.

TensorFlow

TensorFlow usa servicio de TensorFlow para el despliegue del modelo. Servicio de TensorFlow está diseñado para entornos industriales y de producción en mente. La implementación es flexible y de alto rendimiento con una API de cliente REST. Servicio de TensorFlow se integra bien con Docker y Kubernetes.

PyTorch

PyTorch recientemente comenzó a abordar el problema de la implementación. Servicio de antorcha implementa modelos PyTorch. Hay una API RESTful para la integración de aplicaciones. La API de PyTorch es extensible para la implementación móvil. Servicio de antorcha se integra con Kubernetes.

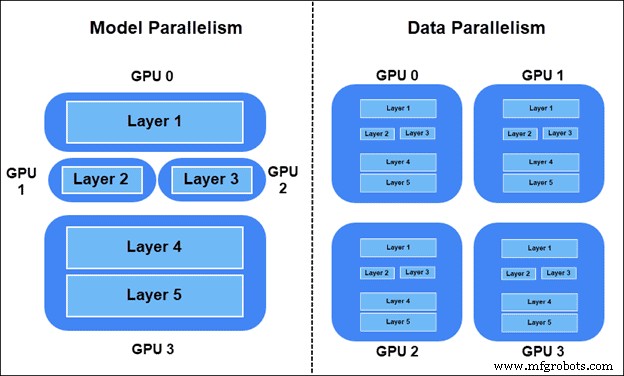

5. Paralelismo y Entrenamiento Distribuido

El paralelismo y el entrenamiento distribuido son esenciales para big data. Las métricas generales son:

- Aumento de velocidad – Proporción de la velocidad de un modelo secuencial (GPU única) en comparación con la velocidad del modelo paralelo (GPU múltiple).

- Rendimiento – El número máximo de imágenes que pasan por el modelo por unidad de tiempo.

- Escalabilidad – Cómo el sistema maneja los aumentos de carga de trabajo.

Hay dos formas de distribuir la carga de trabajo de entrenamiento:

- Modelo de paralelismo – Capas del modelo divididas en diferentes dispositivos. Partes del gráfico se utilizan en el entrenamiento simultáneamente.

- Paralelismo de datos – Todos los dispositivos tienen una copia del modelo completo. Cada dispositivo entrena en diferentes muestras de datos. Se prefiere el método sincrónico SGD (descenso de gradiente estocástico).

Paralelismo del modelo de TensorFlow

Para colocar parte del modelo en un dispositivo específico en TensorFlow, usa tf.device .

Por ejemplo, divida dos capas lineales en dos dispositivos GPU diferentes:

import tensorflow as tf

from tensorflow.keras import layers

with tf.device(‘GPU:0’):

layer1 = layers.Dense(16, input_dim=8)

with tf.device(‘GPU:1’):

layer2 = layers.Dense(4, input_dim=16) Paralelismo del modelo PyTorch

Mueve partes del modelo a diferentes dispositivos en PyTorch usando el nn.Module.to método.

Por ejemplo, mueva dos capas lineales a dos GPU diferentes:

import torch.nn as nn layer1 = nn.Linear(8,16).to(‘cuda:0’) layer2 = nn.Lienar(16,4).to(‘cuda:1’)

Paralelismo de datos de TensorFlow

Para hacer SGD síncrono en TensorFlow, establece la estrategia de distribución con tf.distribute.MirroredStrategy() y ajuste la inicialización del modelo:

import tensorflow as tf strategy = tf.distribute.MirroredStrategy() with strategy.scope(): model = … model.compile(...)

Después de compilar el modelo con el contenedor, entrene el modelo como de costumbre.

Paralelismo de datos de PyTorch

Para SGD síncrono en PyTorch, ajuste el modelo en torch.nn.DistributedDataParallel después de la inicialización del modelo y establezca el rango del número del dispositivo comenzando con cero:

from torch.nn.parallel import DistributedDataParallel. model = ... model = model.to() ddp_model = DistributedDataParallel(model, device_ids=[])

6. Administración de dispositivos

Se producen cambios masivos en el rendimiento cuando se administran dispositivos. Tanto PyTorch como TensorFlow aplican bien las redes neuronales, pero la ejecución es diferente.

TensorFlow

TensorFlow cambia automáticamente al uso de GPU si hay una GPU disponible. Hay control sobre las GPU y cómo se accede a ellas. La aceleración de la GPU está automatizada. Lo que esto significa es que no hay control sobre el uso de la memoria.

PyTorch

PyTorch usa CUDA para especificar el uso de GPU o CPU. El modelo no funcionará sin las especificaciones CUDA para el uso de GPU y CPU. El uso de la GPU no está automatizado, lo que significa que hay un mejor control sobre el uso de los recursos. PyTorch mejora el proceso de entrenamiento a través del control de la GPU.

7. Casos de uso para ambas plataformas de aprendizaje profundo

TensorFlow y PyTorch se utilizaron por primera vez en sus respectivas empresas. Desde que se convirtió en código abierto, también hay muchos casos de uso fuera de Google y Facebook.

TensorFlow

Los investigadores de Google en Google Brain Team primero usaron TensorFlow para proyectos de investigación de Google. Google usa TensorFlow para:

- Resultados de búsqueda y autocompletado.

- Tecnología de voz y voz a texto.

- Reconocimiento y clasificación de imágenes.

- Sistemas de traducción automática.

- Detección de spam para Gmail.

También hay muchos casos de uso fuera de Google. Por ejemplo:

- Sinovation Ventures – Clasificación y segmentación de enfermedades mediante imágenes de retinas.

- PayPal – Detección de fraude con aprendizaje profundo de transferencia y modelado generativo.

- Móvil de China – Sistemas de aprendizaje profundo para la detección de problemas en las redes, predicción automática de ventanas de tiempo de transición y verificación de registros de operaciones.

PyTorch

PyTorch fue utilizado por primera vez en Facebook por Facebook AI Researchers Lab (FAIR). Facebook usa PyTorch para:

- Reconocimiento facial y detección de objetos.

- Filtrado de spam y detección de noticias falsas.

- Automatización del suministro de noticias y sistema de sugerencias de amigos.

- Reconocimiento de voz.

- Sistemas de traducción automática.

PyTorch es de código abierto. Ahora hay muchos casos de uso fuera de Facebook, como:

- CheXNet – Puntuación de probabilidad de neumonía y mapa de calor de rayos X de tórax utilizando redes neuronales convolucionales.

- Piloto automático de Tesla – Multitarea de visión artificial en tiempo real para vehículos autónomos.

- Uber AI Labs PYRO – Lenguaje de programación probabilística para modelado probabilístico profundo. Predicción y optimización de emparejamiento de clientes con conductores, rutas óptimas y vehículos inteligentes de última generación.

¿Deberías usar PyTorch o TensorFlow?

PyTorch es la opción favorita entre programadores e investigadores científicos. La comunidad científica prefiere PyTorch cuando analiza el número de citas. Con las características de implementación y producción recientes, PyTorch es una excelente opción cuando se pasa de la investigación a la producción.

Las organizaciones y las empresas emergentes generalmente usan TensorFlow. Las funciones de implementación y producción otorgan a TensorFlow una buena reputación en casos de uso empresarial. La visualización con Tensorboard también muestra una presentación elegante a los clientes.

PyTorch y TensorFlow son potentes bibliotecas de aprendizaje profundo que se desarrollan de forma intensiva. Hoy en día, hay más similitudes que diferencias entre los dos y cambiar de uno a otro es un proceso fluido.

Computación en la nube

- AWS y Azure:descripción general y comparación de servicios

- IoT en la fabricación:una mirada en profundidad

- GPS vs. RFID:una comparación de tecnologías de localización de activos

- ZigBee vs. XBee:una comparación fácil de entender

- Una comparación de Bluetooth y ZigBee para aplicaciones de IoT

- Comparación del torno de madera CNC con el torno de madera tradicional

- Divisor de voltaje capacitivo:una guía detallada

- Comparación de tecnologías 3D:SLA frente a FDM

- Una mirada en profundidad a la bomba de agua centrífuga

- Una comparación de bruñido y lapeado

- Comparación de bandas transportadoras para minería