Detección de vehículos aéreos no tripulados mediante visión artificial

Resumen

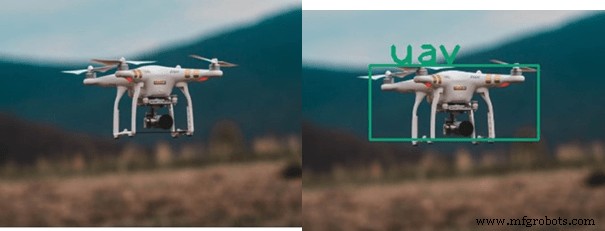

Con la innovación en tecnología, la seguridad se está convirtiendo en el mayor problema a manejar. El aumento exponencial de la accesibilidad de los drones ha planteado una gran amenaza para la seguridad general. El uso de vehículos aéreos no tripulados se ha incrementado en los últimos años. Teniendo en cuenta los problemas de seguridad aquí, se sugiere una solución. Primero, detecte los UAV y luego rastree su ruta.

Para la detección de objetos, los algoritmos de aprendizaje profundo de Computer Vision son muy efectivos. La entrada es procesada por YOLO, que es una red neuronal utilizada para la detección y el seguimiento de objetos en tiempo real.

2.1 Comprender el concepto de UAV

Según el título "Detección y seguimiento de UAV mediante visión artificial", UAV (vehículo aéreo no tripulado) es una aeronave sin piloto, que puede ser controlada remotamente o con computadoras a bordo.

Los vehículos aéreos no tripulados se pueden utilizar para fines beneficiosos como la agricultura, la investigación científica, el pronóstico del tiempo, el envío y la entrega, las operaciones de rescate y la atención médica. Puede usarse para desastres como ataques, ataques con misiles, matanza de objetivos, etc.

2.2 ¿Qué es una visión artificial?

Visión artificial es el campo de la ciencia que hace que las computadoras vean, identifiquen y procesen imágenes de la misma manera que lo hace el ojo humano y proporcionen resultados adecuados. La visión artificial se utiliza en casi todos los campos, es decir:

- Objeto, detección de rostros

- Cirugía robótica y diagnóstico médico

- Procesamiento de imágenes

- Agricultura

- Tecnología espacial (el Mars Rover de la NASA incluye capacidades para modelar el terreno del planeta, detectar obstáculos en su camino y unir imágenes panorámicas) Las aplicaciones de la visión artificial se muestran en la figura 1.4

2.3 ¿Qué es la Técnica de Procesamiento de Imágenes?

El procesamiento de imágenes La técnica es utilizada por la visión artificial para realizar diferentes tareas. La operación realizada y los métodos aplicados para mejorar la calidad de una imagen o para obtener un resultado específico después de obtenerse como una pila de imágenes se denomina procesamiento de imágenes.

El procesamiento de imágenes se considera una de las áreas de tecnología de la información que evoluciona más rápidamente en la actualidad, con aplicaciones en crecimiento en todas las áreas comerciales. Las aplicaciones del procesamiento de imágenes son:

Casos de uso del procesamiento de imágenes

El procesamiento de imágenes se puede utilizar en estos campos:

- Robótica

- Médico

- Reconocimiento de patrones

- Procesamiento de video

- Detección de rostros

2.4 Requisitos de software

- Anaconda

- Espía

- Python

- Biblioteca Open-CV

3. Algoritmos para la detección de objetos

Muchos algoritmos están presentes para la detección de objetos. Algunos de ellos son los siguientes:

- VOILA Y JONES

- Redes neuronales convolucionales (CNN)

- Solo miras una vez (YOLO)

- Detector de disparo único (SSD)

- Redes neuronales convolucionales regionales (R-CNN)

Tabla 3.1:Algoritmos de detección

| Algoritmo | Descripción | Fuerza | Debilidad |

| VOILA AND JONES (La Viola-Jones El algoritmo fue diseñado por Paul Viola y Michael Jones en 2001) | El objetivo principal era la detección de rostros y objetos. Puede detectar objetos en tiempo real. Cuando proporcionamos algoritmos de imagen, observa subregiones más pequeñas e intenta encontrar objetos observando características especiales en cada subregión. El algoritmo de Viola y Jones utiliza características similares a las de Haar para detectar objetos |

|

|

| CNN (Convolutional Neural Networks) Introducido por Kunihiko Fukushima en 1980 | El modelo jerárquico de inspiración biológica que se puede entrenar para realizar la detección, el reconocimiento y la segmentación. Es básicamente un algoritmo de aprendizaje profundo, toma imágenes como entrada, asigna pesos y sesgos que se pueden aprender a los objetos presentes en la imagen y diferencia entre uno y otro |

|

|

| YOLO (Solo miras una vez) | Es un algoritmo de detección en tiempo real. Aplica un algoritmo de red neuronal a la imagen, y divide la imagen en una cuadrícula S x S y crea un límite alrededor de las imágenes y predice posibilidades para cada uno de los límites. Utiliza la regresión. |

| 1. Detecta un objeto por celda de cuadrícula. 2. Prefiere el alto rendimiento a la precisión. |

| SSD (detector de disparo único) | Este método solo toma una sola toma para detectar múltiples objetos, este método es muy rápido. Está diseñado para la implementación en tiempo real. Contiene dos componentes backbone y SSD head. |

|

|

Aquí se utilizará el algoritmo de red neuronal Yolo. Este algoritmo es muy rápido para la implementación en tiempo real. Utiliza un algoritmo de red neuronal y divide la imagen en una cuadrícula S x S y crea un límite alrededor de la imagen para predecir las posibilidades de cada límite. Los algoritmos para la detección se muestran en la Tabla 4.4.

3.1 Algoritmo de Seguimiento

Después de detectar un objeto, el siguiente enfoque está en camino. Si el objeto detectado es una cometa o un pájaro, no es necesario realizar un seguimiento, pero si el objeto detectado es un dron, se realiza un seguimiento del objetivo.

Se utilizan muchos algoritmos para el seguimiento de objetos. Pero nuevamente, YOLO se usa para el seguimiento porque este algoritmo es rápido y preciso y puede detectar y rastrear hasta que el objetivo se mueve fuera del alcance de la cámara.

4. Implementación del diseño propuesto

Aquí está la implementación del diseño propuesto. En el que se realizan todos los pasos necesarios para ejecutar el proyecto en el software.

4.1 Etapa inicial

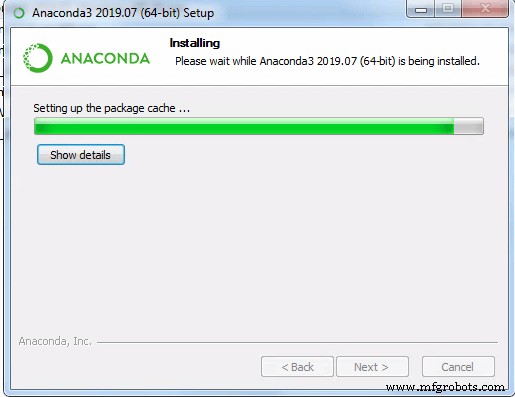

- El procesamiento de imágenes necesita una buena CPU/GPU, elija CPU. Instale la anaconda desde el sitio web La instalación de la anaconda se muestra en la figura 4.1

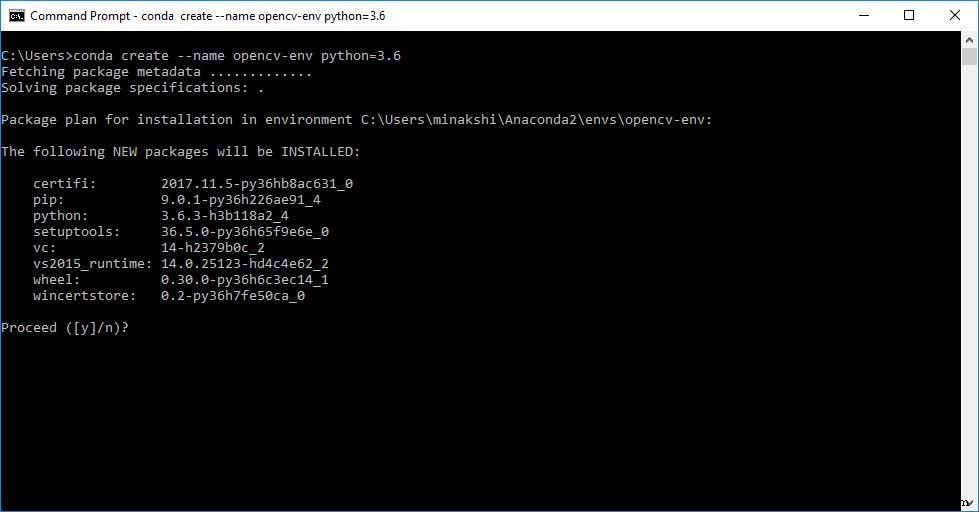

- Después de la instalación de Anaconda Navigator, cree un entorno con la ayuda del cuadro de diálogo del entorno y seleccione la versión de Python.

- Después de crear correctamente un entorno, el siguiente paso es instalar Spyder, ya que es fácil de usar. Luego instale Open CV a través del comando pip install cv2.

4.2 Preparación del conjunto de datos

- Colecciona muchas imágenes de diferentes objetos aéreos como drones, pájaros, aviones, helicópteros, cometas y globos.

Nota: Hacer un conjunto de datos es más que solo recopilar imágenes. Dando los nombres de las imágenes y también diciendo la posición de estos objetos específicos en cada imagen. Para eso, un software llamado Labellmg puede se utiliza, que convierte las imágenes en archivos de texto. Como se muestra en la figura 4.6

- Una vez creados los archivos Txt de todos los objetos. Coloque todas las imágenes y archivos de texto en un archivo zip. Además, archivo de nombre para las clases incluidas.

4.3 Configuración de YOLO

Para la configuración, sigue estos pasos:

- Instalar darknet con YOLO v3.

- Para configurar el YOLO, cree una carpeta en darknet/data que incluya todas las imágenes y archivos .txt del conjunto de datos que se creó anteriormente.

- Para crear un archivo de configuración personalizado, realice las modificaciones requeridas en YOLO v3 de cfg, ajustando lote, subdivisiones y lotes máximos con respecto a clases y pasos.

- Al ingresar el número de clases, cambie la capa convolucional arriba de YOLO. También se establece aleatorio en 1. Los parámetros de cfg se muestran en la Tabla 4.1

Tabla 4.1:Parámetros CFG

| Nombre | Descripción |

| Lote | Cuántas imágenes y etiquetas se utilizan en el pase hacia adelante para calcular un degradado y actualizar los pesos a través del método de propagación hacia atrás. |

| Subdivisiones | El lote se subdivide en muchos "bloques". Las imágenes de un bloque se ejecutan en paralelo. |

| Pasos | 500,1000:ajuste la tasa de aprendizaje después de 500 y 1000 lotes. |

| Capas (Filtros) | Cuántos núcleos convolucionales hay en una capa. |

| Capas (aleatorias) | Pon las capas de YOLO. Si se establece en 1, aumenta los datos cambiando el tamaño de las imágenes a diferentes tamaños cada pocos lotes, que se usa para generalizar sobre los tamaños de los objetos. |

- Hacer una carpeta de objetos personalizados a través de data/obj.names en la que se escriben todos los nombres que queremos detectar como drones, UAVs, pájaros, cometas, etc.

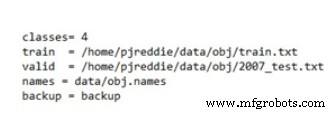

- En obj.data se incluyen y guardan el número de clases, train.txt, válido, nombres y carpeta de pesos.

- En tren.txt se guardan todos los datos y nombres de las imágenes.

4.4 Entrenamiento de YOLO en su conjunto de datos

La capacitación de YOLO para un conjunto de datos personalizado también se realiza a través de la darknet. Clone y habilite darknet, así como también habilite Open CV. Tomando la carpeta ZIP, el archivo .cfg, el archivo .names, el archivo obj.data y el archivo train.txt creados anteriormente, configure la red darknet para el entrenamiento de YOLO v3, contando las ejecuciones.

Después de miles de iteraciones, que pueden demorar aproximadamente 2 horas según la potencia de nuestra CPU, un conjunto de datos entrenados estará listo para usar e integrarse con nuestro sistema, con la pérdida promedio.

4.5 Prueba de código en entrada de imagen y video

Después de entrenar el YOLO para el conjunto de datos personalizado, comience a probar el código en su conjunto de datos entrenados que se llama pesos de YOLO. Tiene 4 clases en este caso.

Pruebe la detección de YOLO en diferentes. Los pesos grandes son buenos en términos de precisión, pero el procesamiento es un poco lento debido a los pocos cuadros por segundo. Haga un video de UAV, pájaros y proporcione estos datos como entrada al código. Todos los objetos serán detectados y rastreados con éxito con las etiquetas dadas fps y umbral.

Ahora el código se puede probar para escenarios en tiempo real a través de la entrada en tiempo real de la cámara web cambiando el rango de nuestra cámara voló nuestro UAV con la grabación del resultado, verá la salida según sea necesario "Detección y seguimiento de UAV".

Tecnología Industrial

- Osciloscopio para PC

- Visión por computadora como sensor de movimiento para SmartThings

- DETECCIÓN HUMANA DE ROBOT SONBI USANDO KINECT Y FRAMBUESA PI

- Los beneficios de utilizar Robotic Vision para aplicaciones de automatización

- 4 ventajas de usar una solución inteligente de detección de fugas en edificios

- 5 ventajas de usar el sistema de detección de fugas de agua impulsado por IoT de Biz4intellias en industrias

- 7 aplicaciones de la visión artificial

- Visión artificial

- Vehículo aéreo no tripulado (UAV) de gran altitud para monitorear parámetros meteorológicos

- Prevención de la deformación de la imagen inducida por el calor en las cámaras de escaneo lineal de visión artificial

- 24 Unidad 7:Mastercam