Abordar el sesgo de entrenamiento en el aprendizaje automático

Enseñar a cualquiera sobre la "justicia" es un objetivo loable.

Como seres humanos, es posible que no estemos necesariamente de acuerdo en lo que es justo. A veces depende del contexto. Enseñar a los niños a ser justos, tanto en casa como en la escuela, es fundamental, pero es más fácil decirlo que hacerlo. Con esto en mente, ¿cómo podemos, como sociedad, comunicar los matices de "ser justos" a los sistemas de inteligencia artificial (IA)?

Un equipo de investigadores de IBM Research está dando la primera solución a este enigma. IBM está lanzando un kit de herramientas para desarrolladores llamado "AI Fairness 360". Como parte de este esfuerzo, IBM ofrece a las empresas un nuevo "servicio de mitigación y detección de sesgos basado en la nube" que las corporaciones pueden usar para probar y verificar cómo se comportan los sistemas impulsados por IA.

En una entrevista telefónica con EE Times, Saska Mojsilovic, miembro de IBM Research, nos dijo que los científicos y los profesionales de la IA se han centrado demasiado en la precisión de la IA. Por lo general, la primera pregunta que la gente hace sobre la IA es:"¿Pueden las máquinas vencer a los humanos?"

Pero, ¿qué pasa con la justicia? El vacío de equidad en la IA tiene el potencial de inducir consecuencias catastróficas en, por ejemplo, la atención médica o los vehículos autónomos, dijo.

¿Qué sucede si un conjunto de datos utilizado para entrenar una máquina está sesgado? Si la IA no puede explicar cómo llegó a una decisión, ¿cómo podríamos verificar su "corrección"? ¿Puede la IA revelar si los datos han sido manipulados de alguna manera durante el procesamiento de la IA? ¿Podría AI asegurarnos que sus datos nunca han sido atacados o comprometidos, incluso durante el procesamiento previo y posterior?

En resumen, ¿existe la IA introspectiva? La respuesta simple:No.

Sin ser transparentes para los usuarios, desarrolladores y profesionales de la IA, los sistemas de IA no pueden ganarse la confianza de la sociedad, dijo Mojsilovic.

Descomposición de la equidad

Una pregunta más importante es cómo enseñarle a la máquina qué es la justicia. Mojsilovic señaló:"Debido a que somos científicos, lo primero que hicimos fue descomponer la 'justicia'. Necesitábamos controlarlo". Rompieron la equidad en términos de métricas, algoritmos y sesgos practicados en la implementación de la IA.

Kush Varshney, científico investigador de IBM, explicó que el equipo analizó el sesgo y la equidad en los algoritmos de inteligencia artificial y la toma de decisiones de inteligencia artificial. “Hay justicia para los individuos y hay justicia para los grupos. Observamos diferentes atributos de los grupos, que van desde el género hasta la raza. También se consideran cuestiones legales y reglamentarias ". Al final, el equipo terminó midiendo 30 métricas diferentes para buscar sesgos en conjuntos de datos, modelos de inteligencia artificial y algoritmos.

Estos hallazgos se incorporan a la caja de herramientas AI Fairness 360 que IBM lanzó esta semana. La compañía lo describió como "un completo conjunto de herramientas de métricas de código abierto para verificar sesgos no deseados en conjuntos de datos y modelos de aprendizaje automático".

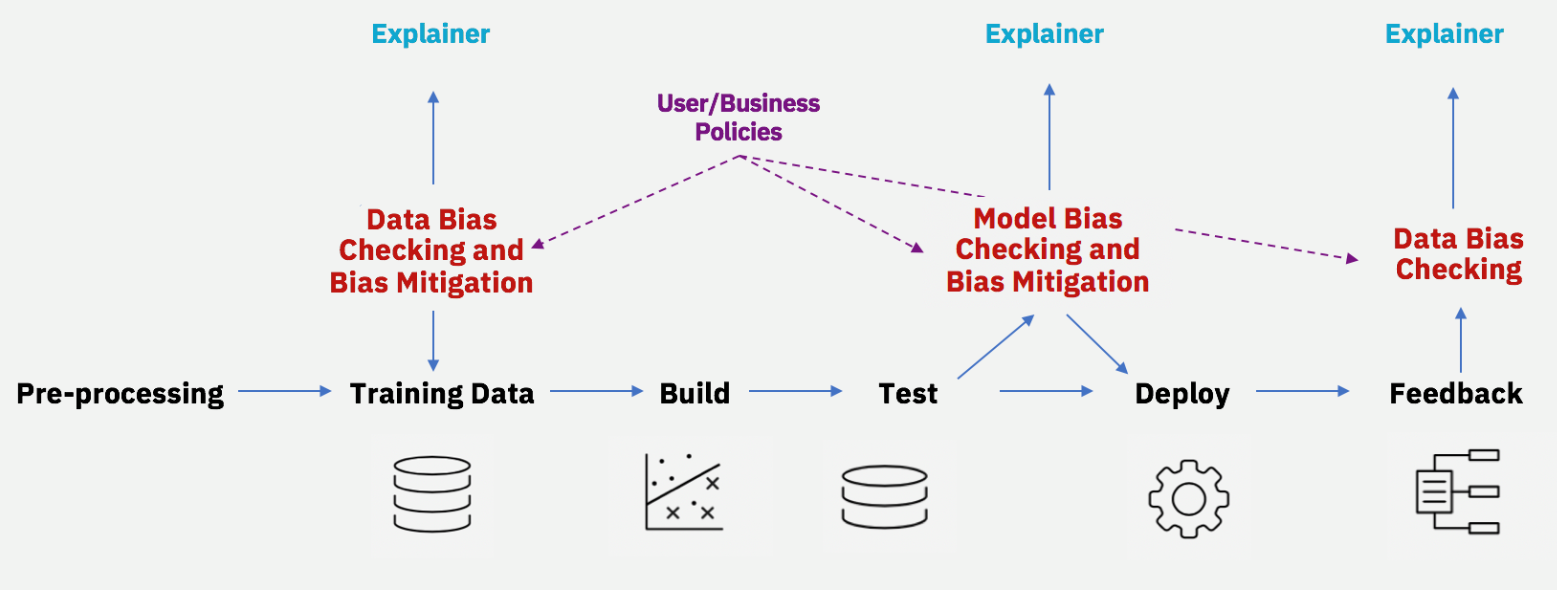

Mitigar el sesgo a lo largo del ciclo de vida de la IA (Fuente:IBM)

Aunque muchos científicos ya están trabajando para detectar la discriminación en los algoritmos de inteligencia artificial, Mojsilovic dijo que el enfoque de IBM difiere al incluir algoritmos no solo para encontrar sesgos, sino también una herramienta para eliminar el brillo.

En un nivel básico, debe preguntarse:Científicos informáticos:¿definen la equidad? ¿Ésta es una tarea normalmente asignada a los científicos sociales? IBM, consciente de esta incongruencia, dejó en claro que ni Mojsilovic ni Varshney están trabajando en el vacío. Trajeron una gran cantidad de académicos e institutos. Varshney participó en la Conferencia de Ética Uehiro-Carnegie-Oxford patrocinada por el Carnegie Council for Ethics in International Affair. Mojsilovic participó en un Taller de IA en Berkeley, California, patrocinado por la Facultad de Derecho de UC Berkeley.

¿Es un algoritmo neutral?

Los científicos sociales han estado señalando el problema del sesgo de la IA durante algún tiempo.

Young Mie Kim, profesor de la Escuela de Periodismo y Comunicación de Masas de la Universidad de Wisconsin — Madison, explicó:“La discriminación de la IA (o sesgo de la IA) puede ocurrir cuando refuerza implícita o explícitamente los prejuicios y órdenes sociales desiguales existentes (por ejemplo, género, raza, edad, situación social / económica, etc.) ". Los ejemplos van desde errores de muestreo (por ejemplo, representación insuficiente de ciertos datos demográficos debido a métodos de muestreo inapropiados o dificultades) hasta sesgos humanos en el entrenamiento de máquinas (modelado). Kim argumentó que el sesgo de la IA existe incluso con "decisiones estratégicas" en el diseño o el modelado, como los algoritmos de publicidad política.

En su reciente estudio titulado "Oportunidad algorítmica:publicidad digital y desigualdad de participación política", Kim demostró cómo se puede reforzar la desigualdad en decisiones basadas en algoritmos.

La comunidad técnica podría argumentar que “un algoritmo es neutral” o puede ser “educado” (capacitado). Kim señaló:"Eso no reconoce que los sesgos entren en cualquier etapa del desarrollo del algoritmo".

Tecnología de Internet de las cosas

- Aprendizaje automático en AWS; Conócelo todo

- La cadena de suministro y el aprendizaje automático

- Maximización de la eficacia del entrenamiento de confiabilidad

- Mobius presenta el software de capacitación en equilibrio de máquinas

- NXP duplica el aprendizaje automático en el borde

- Cómo utilizar el aprendizaje automático en el entorno empresarial actual

- Aprendizaje automático en el campo

- Cómo abordar la curva de aprendizaje de PID

- Aprendizaje automático en mantenimiento predictivo

- Prediga la vida útil de la batería con el aprendizaje automático

- La vida como investigador de inteligencia artificial e ingeniero de aprendizaje automático