Comprimir modelos de IA en microcontroladores

¿Qué obtienes cuando cruzas AI con IoT? La inteligencia artificial de las cosas (AIoT) es la respuesta simple, pero también obtiene un área de aplicación nueva y enorme para microcontroladores, habilitada por los avances en las técnicas de redes neuronales que significan que el aprendizaje automático ya no se limita al mundo de las supercomputadoras. En estos días, los procesadores de aplicaciones para teléfonos inteligentes pueden (y lo hacen) realizar inferencias de IA para el procesamiento de imágenes, motores de recomendación y otras funciones complejas.

Llevar este tipo de capacidad al humilde microcontrolador representa una gran oportunidad. Imagínese un audífono que puede usar IA para filtrar el ruido de fondo de las conversaciones, electrodomésticos inteligentes que pueden reconocer la cara del usuario y cambiar a su configuración personalizada, y nodos de sensores habilitados para IA que pueden funcionar durante años con la más pequeña de las baterías. El procesamiento de los datos en el punto final ofrece ventajas de latencia, seguridad y privacidad que no se pueden ignorar.

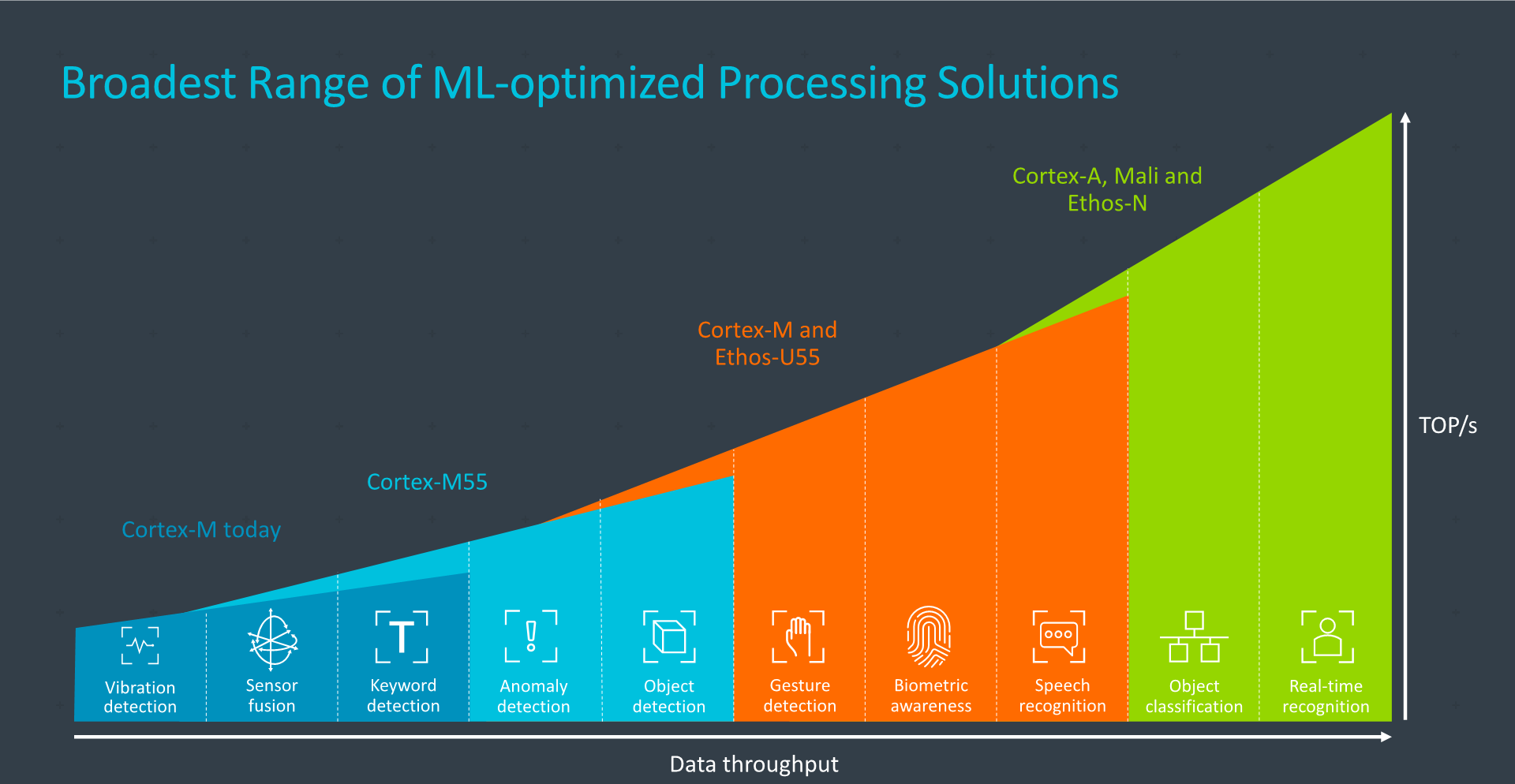

Usados en conjunto, Arm's Cortex-M55 y Ethos-U55 tienen suficiente poder de procesamiento para aplicaciones como reconocimiento de gestos, biometría y reconocimiento de voz ( Imagen:brazo)

Sin embargo, lograr un aprendizaje automático significativo con dispositivos a nivel de microcontrolador no es una tarea fácil. La memoria, un criterio clave para los cálculos de IA, a menudo está muy limitada, por ejemplo. Pero la ciencia de datos avanza rápidamente para reducir el tamaño del modelo, y los proveedores de dispositivos e IP están respondiendo desarrollando herramientas e incorporando características adaptadas a las demandas del aprendizaje automático moderno.

TinyML despega

Como señal del rápido crecimiento de este sector, la TinyML Summit, un nuevo evento de la industria que se celebró en febrero en Silicon Valley, se está fortaleciendo. La primera cumbre, celebrada el año pasado, contó con 11 empresas patrocinadoras; el evento de este año tuvo 27 y las plazas se agotaron mucho antes, según los organizadores. La asistencia a las reuniones globales mensuales de TinyML para diseñadores ha aumentado drásticamente, dijeron los organizadores.

“Vemos un mundo nuevo con billones de dispositivos inteligentes habilitados por tecnologías TinyML que detectan, analizan y actúan de forma autónoma en conjunto para crear un entorno más saludable y sostenible para todos”, dijo el director senior de Qualcomm Evgeni Gousev, copresidente del Comité TinyML , en sus palabras de apertura en una conferencia reciente.

Gousev atribuyó este crecimiento al desarrollo de algoritmos y hardware más eficientes en energía, combinados con herramientas de software más maduras. La inversión corporativa y de capital de riesgo está aumentando, al igual que la actividad de puesta en marcha y fusiones y adquisiciones, señaló.

Hoy, el Comité TinyML cree que la tecnología ha sido validada y que los productos iniciales que utilizan el aprendizaje automático en microcontroladores deberían llegar al mercado en dos o tres años. Se cree que las "aplicaciones asesinas" tardarán entre tres y cinco años.

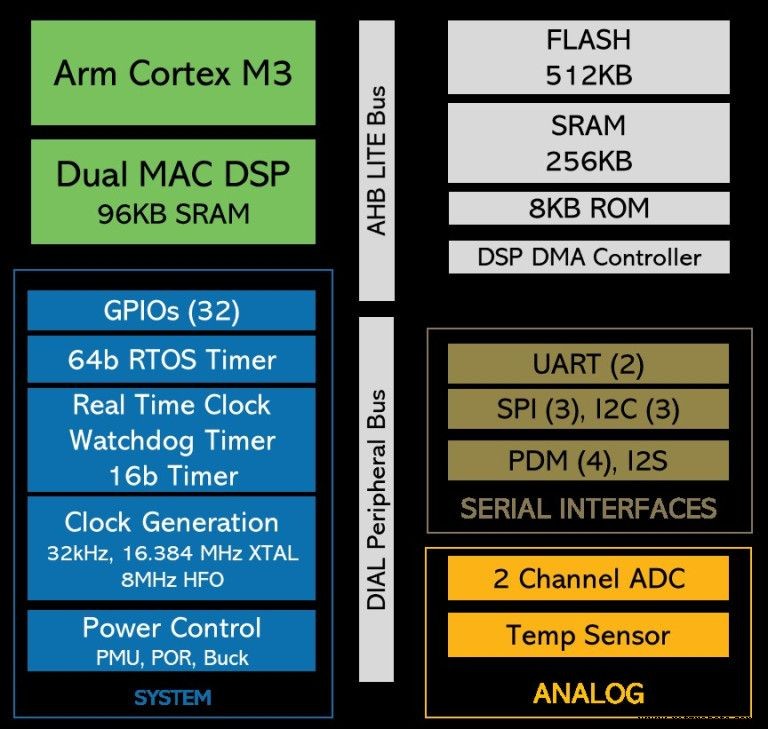

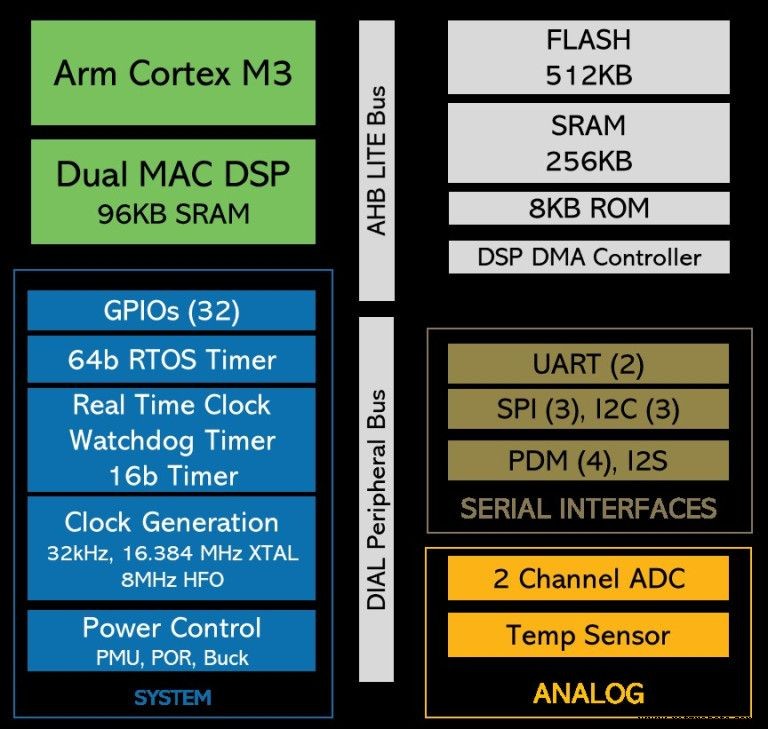

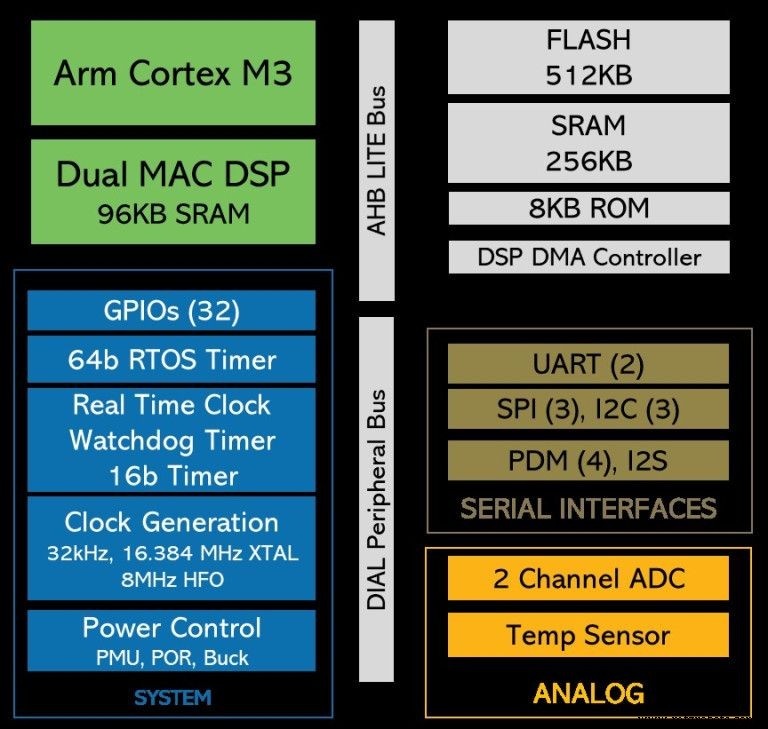

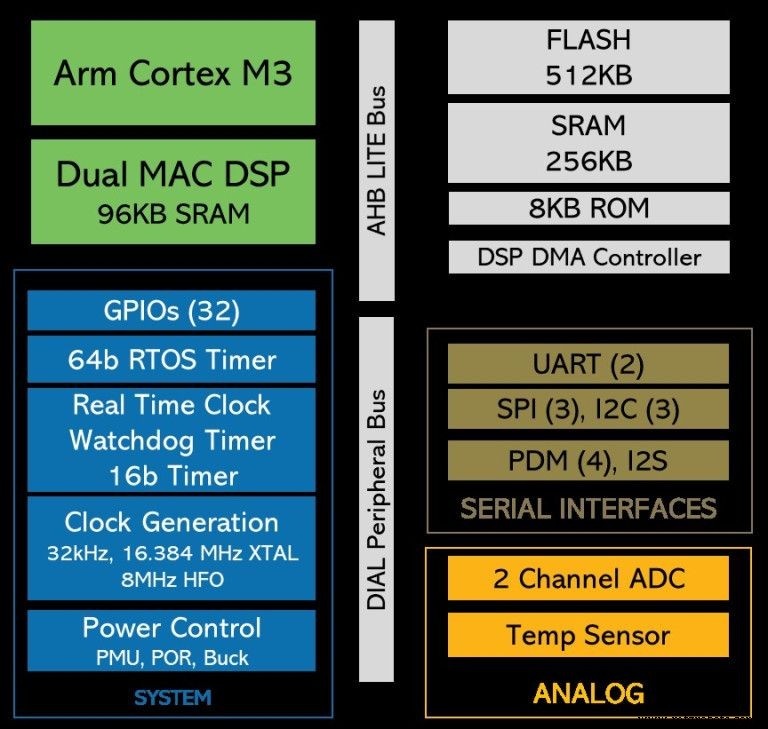

Una gran parte de la validación tecnológica se produjo la primavera pasada cuando Google demostró una versión de su marco TensorFlow para microcontroladores por primera vez. TensorFlow Lite para microcontroladores está diseñado para ejecutarse en dispositivos con solo kilobytes de memoria (el tiempo de ejecución del núcleo cabe en 16 KB en un Arm Cortex-M3; con suficientes operadores para ejecutar un modelo de detección de palabras clave de voz, ocupa un total de 22 KB ). Es compatible con la inferencia pero no con el entrenamiento.

Grandes jugadores

Los grandes fabricantes de microcontroladores, por supuesto, están observando con interés los desarrollos en la comunidad TinyML. A medida que la investigación permite que los modelos de redes neuronales se hagan más pequeños, las oportunidades aumentan. La mayoría tiene algún tipo de soporte para aplicaciones de aprendizaje automático. Por ejemplo, STMicroelectronics tiene un paquete de extensión, STM32Cube.AI, que permite mapear y ejecutar redes neuronales en su familia STM32 de microcontroladores basados en Arm Cortex-M.

El entorno de desarrollo de e-AI de Renesas Electronics permite implementar la inferencia de AI en microcontroladores. Traduce efectivamente el modelo a una forma que se puede utilizar en el estudio e2 de la empresa, compatible con proyectos C / C ++.

NXP Semiconductors dijo que tiene clientes que utilizan sus MCU Kinetis y LPC de gama baja para aplicaciones de aprendizaje automático. La compañía está adoptando la inteligencia artificial con soluciones de hardware y software, aunque principalmente orientada a sus procesadores de aplicaciones más grandes y procesadores cruzados (entre procesadores de aplicaciones y microcontroladores).

Fuerte armado

La mayoría de las empresas establecidas en el ámbito de los microcontroladores tienen una cosa en común:Arm. El gigante del núcleo del procesador integrado domina el mercado de los microcontroladores con su serie Cortex-M. La compañía anunció recientemente el nuevo núcleo Cortex-M55, que está diseñado específicamente para aplicaciones de aprendizaje automático, especialmente cuando se usa en combinación con el acelerador de inteligencia artificial Ethos-U55 de Arm. Ambos están diseñados para entornos con recursos limitados. Pero, ¿cómo pueden las nuevas empresas y las empresas más pequeñas competir con los grandes actores de este mercado?

“No construyendo SoCs basados en Arm, porque [los jugadores dominantes] lo hacen realmente bien”, se rió el CEO de XMOS, Mark Lippett. "La única forma de competir contra esos tipos es tener una ventaja arquitectónica ... [eso significa] las capacidades intrínsecas del Xcore en términos de rendimiento, pero también la flexibilidad".

Xcore.ai de XMOS, su procesador cruzado recientemente lanzado para interfaces de voz, no competirá directamente con los microcontroladores, pero la opinión sigue siendo cierta. Cualquier empresa que fabrique un SoC basado en Arm para competir con los grandes será mejor que tenga algo bastante especial en su salsa secreta.

>> Continúe leyendo la página dos de esto artículo publicado originalmente en nuestro sitio hermano, EE Times Europe.

Incrustado

- Modelos SPICE

- Modelos de amplificador operacional

- Kit de modelo de juguete

- Memoria de cambio de fase incorporada de muestreo ST para microcontroladores automotrices

- NVIDIA:computadora CUDA-X AI que ejecuta todos los modelos AI

- Salvavidas

- Cómo hacer fibra de vidrio

- Modelado de materiales de metales en Abaqus

- HPE aplica DevOps a los modelos de IA

- Convertir datos en decisiones

- Aplicaciones de Centros de Maquinado. ¿Modelos y aplicaciones?